Une équipe associant le CNRS au National Institute of Advanced Industrial Science and Technology japonais a développé une interface neuronale directe qui permet de contrôler un robot humanoïde par la pensée pour exécuter différentes variétés d’actions. Le professeur Abderrahmane Kheddar, directeur de recherche au CNRS, a répondu aux questions de Futura-Sciences.

Les chercheurs travaillent depuis longtemps sur le contrôle par la pensée d’avatars virtuels ou de robots via ce que l’on appelle une interface neuronale directe ou brain computer interface (BCI). En analysant l’activité électrique émise par le cerveau humain via un casque EEG (électroencéphalographie), il est possible de dégager des modèles neuronaux, liés à certaines actions, qui peuvent être exploités pour transmettre une intention à un ordinateur et exécuter une tâche.

Pour le moment, les expérimentations de contrôle d’avatars et de robots via une BCI se limitent à accomplir une seule tâche. Mais une équipe de chercheurs franco-japonais réunis au sein du Joint Robotics Laboratory (JRL) a développé une interface neuronale directe qui permet un contrôle multitâche d’un robot humanoïde pour le déplacer et lui faire saisir des objets. Une avancée qui ouvre de nouvelles perspectives pour les personnes tétraplégiques auxquelles ce type d’outils de contrôle pourrait un jour apporter une plus grande autonomie.

Une collaboration franco-japonaise

Le JRL est une unité mixte internationale entre le CNRS (Centre national de la recherche scientifique) et l’AIST (Advanced Industrial Science and Technology japonais). À sa tête, le professeur Abderrahmane Kheddar, directeur de recherche au CNRS, assisté de deux doctorants. Les travaux du Joint Robotics Laboratory s’inscrivent dans le cadre du projet européen Vere (virtual embodiment and robotic re-embodiment) qui consiste à « dissoudre la frontière entre le corps humain et ses substituts . Dissoudre la frontière signifie que les gens ont l’illusion que leur substitut est leur propre corps qui agit et pense en conséquence ».

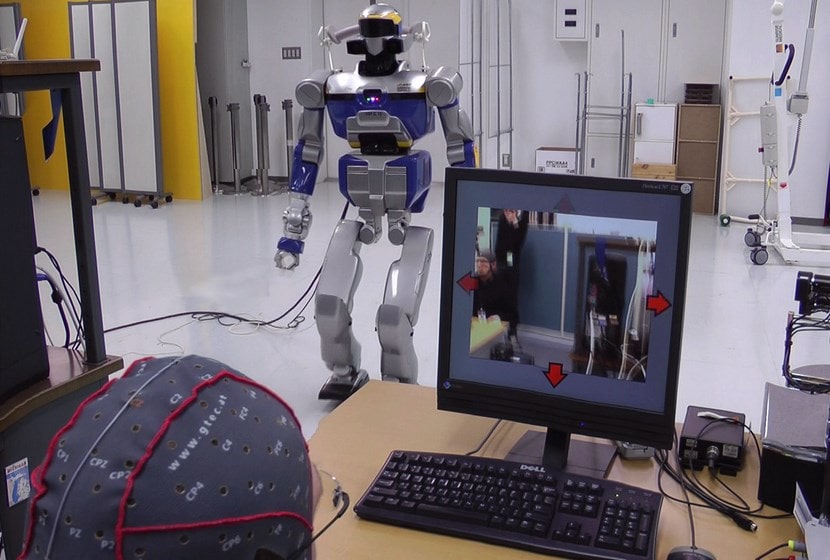

Au premier plan, on distingue l’opérateur humain équipé d’un casque EEG. L’écran affiche la vue subjective retransmise par le robot équipé de caméras. En concentrant son attention sur l’une des flèches rouges de direction qui se superposent en réalité augmentée et auxquelles sont associées des actions, la personne indique son intention au logiciel qui détecte les signaux neuronaux correspondants et envoie la commande au robot. © CNRS-AIST JRL

Le JRL travaille sur cette interface de contrôle multitâche depuis juin 2010 a précisé à Futura-Sciences le professeur Kheddar. En combinant réalité augmentée, reconnaissance d’image et électroencéphalographie, l’interface associe des icônes correspondant à des tâches avec ce que voit le robot. Cela permet à l’utilisateur de le commander en concentrant son attention sur lesdites icônes. Dans le détail, une personne munie d’un casque EEG se tient devant un écran d’ordinateur relié au robot qui est équipé de caméras afin de fournir une vue subjective qui crée le sentiment d’immersion. Grâce à un procédé de réalité augmentée, des flèches de direction qui clignotent très rapidement se superposent à l’image réelle. La personne fixe son regard sur l’une des flèches pour mouvoir le robot.

Interface de contrôle multitâche

« L’acquisition des activités du cerveau ne permet pas encore d’extraire « une pensée » ou encore le « vouloir en termes de tâches » des usagers : on est très loin, nous a expliqué le professeur Kheddar. Ce que permet la technologie actuellement est de retrouver un stimulus dans ces signaux. Par exemple, on propose au système sensoriel humain des « événements » sous forme de stimulus sensoriel et on regarde si ces événements peuvent être retrouvés dans les signaux extraits du cerveau comme réponse à ce stimulus. » Les flèches clignotantes correspondent au stimulus sensoriel évoqué qui est analysé grâce au modèle neuronal SSVEP (steady-state visually evoked potentials) qui « désigne la possibilité de retrouver la fréquence d’un clignotement visuel sur lequel l’opérateur porte son attention ». Ainsi, poursuit le chercheur, « pour faire faire à un robot humanoïde des tâches, il suffit d’associer à des « icônes » de l’image des tâches qui seront exécutées à chaque fois que l’opérateur porte son attention sur une icône particulière ».

Outre les déplacements, l’interface de contrôle développée par le JRL permet également d’interagir avec des objets. Pour cela, le système utilise la reconnaissance d’image afin d’identifier des objets auxquels sont associées des tâches. « On utilise le principe d’affordance pour associer des tâches à des objets », explique le professeur Kheddar. Selon la définition, le concept d’affordance recouvre la « capacité d’un objet à suggérer sa propre utilisation ». Dans le cas du système de contrôle du JRL, cela passe par une phase d’apprentissage du robot qui doit pouvoir reconnaître les objets qu’il rencontre afin d’exécuter les tâches qui leur ont été assignées. Dans les essais réalisés par les chercheurs, le robot approche d’une table où sont posées deux canettes de boisson. Le logiciel détecte les objets et active la réalité augmentée.

À l’écran, l’utilisateur voit des formes de couleur clignotantes se superposer sur les deux canettes. En concentrant son attention sur l’une des deux formes clignotantes, la personne indique laquelle le robot doit saisir. « Chaque objet reconnu de la scène clignotera à une fréquence désignée, et si l’attention de l’opérateur est portée sur un objet, cela enclenchera la tâche qui lui est associée et qui sera donc exécutée par le robot. »

Le chemin est encore long…

Bien sûr, nous sommes encore loin d’un système entièrement polyvalent, capable d’exécuter n’importe quelle tâche. Abderrahmane Kheddar nous a notamment expliqué que les principaux obstacles à surmonter concernent le rapport signal sur bruit de l’EEG qui est de « piètre qualité » ainsi que la latence dans le traitement des signaux pour opérer une classification SSVEP. Le travail de développement va donc se poursuivre. Prochaine étape, des essais avec des personnes paralysées. « Nous envisageons de faire des expériences avec des tétraplégiques et de faire du contrôle continu du mouvement robotique avec une véritable commande en boucle fermée », précise le directeur du JRL.

Quand un tel système sera-t-il fonctionnel et utilisable par le grand public ? « Difficile d’avoir une estimation correcte », répond le professeur Kheddar qui estime qu’il faudrait compter une quinzaine d’années, le temps que des robots humanoïdes plus sophistiqués fassent leur apparition et que la technologie BCI progresse elle aussi. « Mais une trouvaille originale pourrait accélérer l’ensemble », conclut-il.

Pour aller plus loin :

– Les robots télépathique débarquent

{jacomment on}