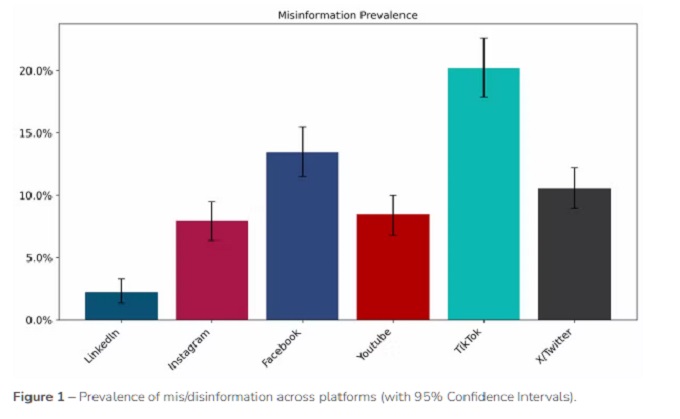

La désinformation en ligne circule plus vite et plus fort qu’on ne le croit. Elle prend des proportions inédites en Europe, un phénomène auquel il est désormais impossible d’échapper — surtout sur certaines plateformes où une vidéo ou un post peut devenir viral en quelques heures. Des millions de vidéos, de posts, de partages… et, derrière, un brouillard d’informations trompeuses. En Europe, une équipe de chercheurs a entrepris de mesurer l’invisible : la place du faux dans nos fils d’actualité. Cette première analyse indépendante de la désinformation en ligne en Europe révèle que 20 % des publications sur TikTok sont trompeuses, bien plus que sur d’autres grandes plateformes. Autre verdict : la désinformation prospère là où l’attention rapporte. Publiée en septembre 2025, cette recherche livre les premières mesures comparatives de la désinformation sur six grandes plateformes en Europe : TikTok, Facebook, X (Twitter), YouTube, Instagram et LinkedIn.

Avec la montée des préoccupations liées à la désinformation en ligne, notamment dans l’espace politique, sanitaire ou sociétal, il est devenu crucial de pouvoir mesurer non seulement quelle proportion de contenu est à faible crédibilité, mais aussi quel impact ces contenus peuvent avoir sur les utilisateurs. Le projet SIMODS, conduit par Science Feedback en partenariat avec plusieurs organismes européens (Université ouverte de Catalogne, Newtral, Check First, Demagog SK, Pravda) vise à élaborer des « indicateurs structurels » (Structural Indicators) permettant d’évaluer la prévalence, la portée, la monétisation et la présence inter-plateformes de la désinformation. En pleine période de régulation européenne accrue, ce rapport soulève des questions clés sur la manière dont les plateformes traitent la désinformation. Des données robustes et une méthodologie transparente permettent désormais de mieux comprendre l’ampleur de ce phénomène, pour six très grandes plateformes en Europe, dans quatre pays de l’UE (France, Espagne, Pologne, Slovaquie).

Pour la première fois, une étude européenne tente de mesurer précisément la présence, la visibilité et la rentabilité de la désinformation sur les grandes plateformes numériques. Publiée le 29 septembre 2025 par Science Feedback, elle s’impose déjà comme un jalon dans la compréhension de ce phénomène aux conséquences politiques et sociales profondes. Herbert Schiller mettait déjà en avant la « packaged consciousness » : aujourd’hui, ce sont des algorithmes et des plateformes qui façonnent les croyances.

Une démarche scientifique, enfin

Mesurer la désinformation n’a rien d’évident. Comment quantifier le faux ? Comment évaluer sa diffusion ?

Les chercheurs du projet SIMODS ont relevé le défi. Leur approche : sélectionner, dans quatre pays européens (France, Espagne, Pologne et Slovaquie), des milliers de publications traitant de sujets d’intérêt public — politique, santé, environnement, migration…

Chaque contenu a été évalué par des fact-checkers professionnels pour déterminer s’il contenait une information trompeuse. Les équipes ont ensuite observé combien d’interactions ces contenus suscitaient et sur quelles plateformes leur visibilité explosait.

“L’objectif n’est pas de pointer du doigt une plateforme ou un pays, explique l’équipe de Science Feedback. Il s’agit de construire des indicateurs comparables, scientifiques, pour suivre l’évolution de la désinformation dans le temps.”

Des chiffres parlants : jusqu’à 20 % de contenus trompeurs

Les résultats sont sans appel. Parmi les publications analysées, la proportion de contenus à faible crédibilité varie considérablement d’une plateforme à l’autre :

- TikTok arrive en tête, avec environ 20 % de contenus trompeurs.

- Facebook suit avec 13 %,

- X (Twitter) avec 11 %,

- YouTube et Instagram autour de 8 %,

- LinkedIn ferme la marche, avec seulement 2 %.

Une “prime à la désinformation”

L’un des constats les plus préoccupants de l’étude est ce que les chercheurs appellent le « misinformation premium » : les publications trompeuses attirent souvent plus d’engagement que les contenus vérifiés. Les résultats sont frappants. Parmi les contenus étudiés, la part de désinformation varie fortement d’une plateforme à l’autre. Les comptes qui diffusent régulièrement de la désinformation génèrent en moyenne :

- 8 fois plus d’interactions sur YouTube,

- 7 fois plus sur Facebook,

- 5 fois plus sur X et Instagram,

- 2 fois plus sur TikTok.

Sur TikTok, un post sur cinq contenant une information publique peut être trompeur. Sur LinkedIn, plus professionnel et modéré, la désinformation reste marginale. Autrement dit, la désinformation ne se contente pas d’exister : elle se propage plus efficacement que la vérité. Ce déséquilibre crée un environnement où les contenus mensongers bénéficient d’une visibilité disproportionnée, alimentant leur viralité.

Les contenus faux séduisent davantage. Les comptes identifiés comme peu crédibles génèrent jusqu’à huit fois plus d’interactions que les sources fiables :

- YouTube : ×8

- Facebook : ×7

- X et Instagram : ×5

- TikTok : ×2

Ce phénomène révèle une mécanique perverse : plus un contenu est faux, plus il attire. Les chercheurs y voient une conséquence directe des algorithmes de recommandation, conçus pour valoriser les contenus engageants, pas forcément les plus véridiques. Le lien entre répétition algorithmique et persuasion est évident : plus un message circule, plus il devient crédible : « L’individu moderne ne croit plus ce qu’il ignore ; il croit ce qu’il lit, ce qu’il voit, ce qu’il entend sans cesse répété. » déclarait Jacques Ellul (Propaganda, 1962).

La désinformation n’est plus seulement un mensonge, mais une construction du réel à part entière. Jean Baudrillard aussi nous rappelle que les signes peuvent devenir réalité dans l’univers numérique :

Le simulacre n’est jamais ce qui cache la vérité — c’est la vérité qui cache qu’il n’y en a pas. Le simulacre est vrai. »

Jean Baudrillard — Simulacres et Simulation (1981)

L’économie du faux

Derrière la désinformation, il y a aussi un marché. Si les données disponibles restent fragmentaires, les chercheurs ont mis au jour un fait dérangeant : certains créateurs de contenus trompeurs sont bel et bien monétisés, notamment sur YouTube et Facebook. Autrement dit, le faux peut rapporter gros. Plus un contenu choque, divise ou intrigue, plus il attire de clics ; plus il attire de clics, plus les algorithmes le propulsent ; et plus il gagne en visibilité, plus il devient rentable.

La désinformation n’est donc pas seulement un phénomène viral : elle s’inscrit dans une véritable économie de l’attention, où la provocation vaut capital.

Sur YouTube, plusieurs chaînes à « faible crédibilité » participent au programme publicitaire officiel, transformant le mensonge en produit marchand. Une mécanique implacable se met en place : le contenu qui manipule alimente le flux, le flux génère des revenus, et les revenus encouragent la reproduction du contenu.

C’est ce que le sociologue Herbert Schiller décrivait déjà dans les années 1970 : « Les communications de masse fabriquent une conscience empaquetée, façonnée pour servir les intérêts du pouvoir économique. » (Communication and Cultural Domination, 1976). Plus d’un demi-siècle plus tard, cette intuition trouve un écho saisissant dans le paysage numérique actuel : la désinformation s’industrialise, portée non plus par des États ou des idéologies, mais par des plateformes dont le moteur premier reste la rentabilité.

Des réseaux interconnectés

Autre constat majeur : la désinformation ne reste pas confinée à une seule plateforme.

Les chercheurs montrent que les comptes douteux opèrent souvent sur plusieurs réseaux — Facebook, X, YouTube —, créant un écosystème parallèle où les mêmes récits circulent, se renforcent et se réinventent. Cette porosité rend la modération complexe : lorsqu’un compte est suspendu sur un réseau, il continue d’exister ailleurs, parfois avec un public encore plus large.

Le fait que la prévalence et la prime à la désinformation varient fortement selon la plateforme met en évidence que chaque service — par ses algorithmes, ses formats, ses audiences et ses politiques — présente des profils de risque différents. Par exemple, TikTok présente la plus forte proportion (~20 %) de contenu à faible crédibilité dans ce type d’échantillon. LinkedIn présente une très faible proportion (~2 %). Mais, sur TikTok, même si la proportion est élevée, la prime à la désinformation (augmentation d’interactions) est plus faible (~2×) que sur d’autres plateformes.

Cela suggère que la combinaison « format + audience + algorithme » est déterminante.

Sur les plateformes, ce qui est partagé peut devenir “réel” pour les utilisateurs, même si c’est trompeur — la frontière entre “information” et “spectacle” se brouille expliquait Baudrillard. La désinformation ne serait pas seulement un mensonge ou une erreur : elle participe à la construction d’un monde de signes et de représentations qui remplace ou modifie la réalité. Et, comme l’anticipait Ellul, la propagande n’est pas seulement un message mais un environnement.

Visibilité disproportionnée des acteurs à faible crédibilité

Le constat est inquiétant : sur plusieurs plateformes, les comptes identifiés comme peu crédibles obtiennent cinq à huit fois plus d’interactions par publication que les sources d’information fiables. Autrement dit, un contenu douteux peut circuler plus largement qu’un contenu vérifié, non pas parce qu’il est vrai, mais parce qu’il est plus visible. Ce déséquilibre nourrit un écosystème de viralité artificielle, où la popularité tient lieu de preuve et où la désinformation s’impose par simple effet d’amplification.

Les auteurs de l’étude y voient l’un des risques systémiques que le Digital Services Act (DSA) de l’Union européenne cherche précisément à encadrer. Entré en vigueur en 2024, ce règlement impose aux très grandes plateformes — celles comptant plus de 45 millions d’utilisateurs dans l’UE — de mesurer, réduire et rendre publiques les menaces liées à la désinformation. Il exige notamment des entreprises qu’elles ouvrent leurs données aux chercheurs et qu’elles rendent leurs algorithmes plus transparents, afin d’évaluer les mécanismes de recommandation qui favorisent ces dynamiques.

En d’autres termes, le DSA marque un tournant : il ne s’agit plus seulement de modérer des contenus, mais de réguler les architectures de visibilité elles-mêmes — ces algorithmes invisibles qui décident, chaque seconde, de ce qui mérite d’être vu ou oublié.

LinkedIn, l’exception tranquille

Fait marquant, LinkedIn semble presque épargné. Seulement 2 % des contenus y sont jugés à faible crédibilité. Pourquoi ? Sans doute parce que son modèle repose sur l’identité réelle et la réputation professionnelle, limitant les comportements anonymes et sensationnalistes. Jean Baudrillard disait que « Ce n’est pas la réalité qui est truquée, mais la vérité qui ne trouve plus où se loger. » (La Guerre du Golfe n’a pas eu lieu (1991))

Ce contraste montre qu’il est possible de concevoir des environnements numériques plus résistants à la désinformation — à condition que les plateformes en fassent un objectif explicite.

Les grandes leçons de l’étude SIMODS :

- La désinformation touche toutes les plateformes, à des degrés très variables.

- Les contenus trompeurs génèrent plus d’engagement que les contenus vérifiés.

- Certains acteurs désinformateurs parviennent à monétiser leur activité.

- Les plateformes ont un rôle structurel majeur : leurs algorithmes amplifient ou freinent la viralité.

Un enjeu démocratique

Au-delà des chiffres, l’enjeu est profondément politique. Et c’est la santé même du débat public qui se joue. La désinformation ne se contente pas de brouiller la compréhension des faits : elle modifie les perceptions, polarise les échanges et fragilise la confiance qui fonde toute vie démocratique. Dans un espace numérique où les émotions circulent plus vite que les preuves, la vérité devient un terrain mouvant — et la démocratie, un exercice d’équilibre permanent.

C’est précisément ce type de dérive que le Digital Services Act (DSA) de l’Union européenne entend contenir, comme expliqué plus haut. Ce règlement impose aux très grandes plateformes de cartographier leurs risques systémiques, de rendre leurs données accessibles aux chercheurs et de rendre compte publiquement des mesures prises pour limiter la désinformation, les manipulations de contenu et les atteintes au débat civique. Pour la première fois, la responsabilité des plateformes est pensée non plus seulement en termes de modération, mais de transparence structurelle.

Dans cette perspective, l’étude de Science Feedback s’inscrit comme un maillon essentiel. En transformant un phénomène diffus en objet de mesure scientifique, elle ouvre la voie à un suivi régulier et comparatif de la désinformation. C’est une étape décisive : sans observation rigoureuse, aucune politique publique ne peut espérer restaurer durablement la confiance dans l’information.

La vérité à l’épreuve de la viralité

La leçon de cette étude tient en une phrase : la popularité d’un post ne garantit en rien sa fiabilité et n’est pas la preuve. Dans un monde où les clics dictent la visibilité, la vérité avance souvent plus lentement que le mensonge. Mais elle avance.

Et grâce à des initiatives comme SIMODS, la recherche commence enfin à mettre des chiffres, et non plus seulement des peurs, sur un phénomène qui redessine nos démocraties.

Pour les utilisateurs, cela rappelle l’importance de la vigilance : le fait qu’un contenu soit populaire ne le rend pas fiable. Pour les plateformes et régulateurs, l’étude plaide en faveur d’indicateurs standardisés, réguliers et publics pour mieux appréhender et contrôler la désinformation.

Que reste-t-il de la “réalité” dans un univers médiatisé où la désinformation participe de la “réalité” ?

Selon Ellul, la propagande moderne ne se limite pas à un simple message unique, mais à un environnement communicatif total : « les médias de masse rendent possible l’usage des techniques de propagande à l’échelle sociétale ». Il écrivait aussi : « trop de données ne renforcent pas la compréhension ; elles noient l’individu ». Cette idée se rapproche des effets de surcharge d’information ou de saturation qu’on observe dans les réseaux sociaux. Pour Ellul, la désinformation ne se réduit pas aux “posts faux” mais s’inscrit dans une logique de système médiatique où les formats, l’instantanéité et la technique (algorithmes, plateforme) jouent un rôle de cœur ( Propaganda: The Formation of Men’s Attitudes (1962) et The Technological Society (1964).

Whitney Phillips, spécialiste des études sur l’internet, la désinformation, le trolling, montre comment les dynamiques en ligne, y compris l’humour, le chaos, le trolling, participent à la diffusion de contenus anti-normatifs et trompeurs, production non plus essentiellement top-down (propagande d’Etat), mais horizontale, amateure, communautaire.

Entre lucidité et responsabilité

Dans l’univers saturé d’images, de flux et de notifications qui composent notre quotidien numérique, la désinformation n’est plus une anomalie : elle est devenue l’un des régimes ordinaires de la visibilité. Comme l’avaient pressenti Ellul ou Baudrillard, nous ne vivons plus seulement dans un espace d’information, mais dans un écosystème de représentations, où la perception finit souvent par supplanter le réel.

Pourtant, tout n’est pas perdu. Les chiffres du projet SIMODS rappellent qu’il est encore possible de mesurer, comprendre et agir. En objectivant la désinformation, la recherche ne cherche pas à la faire taire, mais à la rendre visible, à rétablir des repères là où la confusion prospère. C’est un premier pas, fragile mais essentiel, vers une écologie plus saine de l’information.

Reste alors la question de notre responsabilité collective. Car si la désinformation est un système, elle se nourrit aussi de nos gestes : nos clics, nos partages, nos silences. La vérité, elle, demande du temps, de l’attention, et peut-être surtout une certaine patience démocratique — celle qui consiste à douter, à vérifier, à ralentir avant de relayer.

Ainsi, dans la grande course de la viralité, il ne s’agit plus seulement de défendre la vérité, mais de lui redonner le temps d’exister.

Fabienne Marion, Rédactrice en chef UP’