Nous vivons une époque où les promesses du numérique côtoient ses ombres inquiétantes. Les technologies qui, hier encore, nous promettaient un monde interconnecté, transparent et accessible, révèlent aujourd’hui des effets secondaires qui résonnent comme des alertes. À l’instar des armes nucléaires, le numérique présente des conséquences immédiates, mais aussi des effets insidieux et prolongés. De la manipulation de l’information sur les réseaux sociaux aux transformations profondes de nos comportements sociaux et cognitifs, ces évolutions redéfinissent nos sociétés. L’addiction aux écrans, la perte de contact avec la réalité tangible, et la pression consumériste exacerbée, entre autres, traduisent une mutation culturelle sans précédent, avec des implications environnementales, économiques et politiques majeures. À l’ère numérique, l’être humain doit réapprendre à trouver son équilibre entre innovation et sauvegarde des valeurs fondamentales.

Je pense qu’il est juste de dire que nous fûmes trop idéalistes, et seulement soucieux du bien qu’il y a à connecter les gens entre eux et à leur donner une capacité d’expression…Nous n’avons sans doute pas fait assez attention aux aspects négatifs… »

Mark Zuckerberg, fondateur de Facebook

Ce qui caractérise en particulier l’arme nucléaire est, d’une part, l’étendue de ses effets immédiatement dévastateurs, mais, d’autre part, la rémanence d’effets prolongés, sinon définitifs, liés au caractère toxique de ses composants radioactifs : sur les organismes immédiatement atteints, mais aussi sur ceux qui seront exposés aux contaminations radioactives à (très) long terme (2) .

Aujourd’hui, ne peut-on considérer que les systèmes numériques comme présentant les mêmes caractéristiques, comme des effets immédiatement dévastateurs par les manipulations commerciales, les fausses informations diffusées par les réseaux, par les manipulations pirates qui peuvent paralyser certain réseaux et/ou des applications essentielles ou « simplement » en voler les données ; mais aussi les effets à long terme sur les individus et certains effets irréversibles induits du fait notamment de leurs conséquences sur le développement mental et les relations avec le monde réel et/ou les communautés sociales.

Et ce, déjà constaté dès l’enfance dans une altération de leurs moyens d’accès aux connaissances : capacité de lecture-écriture, relations avec les enseignants, sélectivité des sources éducatives et de formation, y compris culturelles, addiction aux écrans, privilège donné aux opinions personnelles au dépend de celles issues des cultures communautaires et un égo-centrisme narcissique stimulé notamment par les pratiques commerciales.

« La société numérique ressemble à un peuple de drogués hypnotisés par l’écran » comme le résume un spécialiste des médias, Bruno Patino, dans son livre intitulé « La civilisation du poisson rouge » (3) . Il poursuit : « Nous sommes devenus des poissons rouges, enfermés dans le bocal de nos écrans, soumis au manège de nos alertes et de nos messages instantanés ».

L’ensemble de ces effets se traduisent déjà par une évolution significative et sans doute irréversible des mentalités et des comportements sociaux, mettant sans aucun doute en cause certains acquis liés au développement de l’ensemble des organisations ayant créé des formes diverses de solidarité sociétale : régimes politiques, organisations et réglementations sociales, monde associatif et culturel, …

Comme l’analyse Benoit Sillard (4) , internet et ses suites deviennent ainsi peu à peu une sorte de second cerveau, une source d’informations inépuisables et disponibles en permanence. Est-ce une chance, une menace ? Les réseaux sont-ils un formidable vecteur d’intelligence collective, ou un éteignoir de l’esprit critique ? A noter à ce sujet la mauvaise traduction en français du concept d’« intelligence artificielle », le mot « intelligence » en anglais signifiant aussi « connaissance », comme dans le cas de l’« Intelligence Service » collectant des informations. Le programme Chat-GPT synthétise des connaissances existantes mais n’en analyse pas (encore) le sens de façon « intelligente » … En termes généraux, l’IA désigne les systèmes qui, sur la base d’un grand nombre de données, peuvent accomplir diverses tâches avec un certain degré d’autonomie. Cela inclut l’utilisation d’algorithmes pour identifier des similitudes et des modèles et classer et utiliser les données à des fins de prognose. L’IA comprend également différents types d’apprentissage automatisé.

Benoit Sillard met aussi en lumière les enjeux majeurs des prochaines décennies : accès aux réseaux de la connaissance, nouvelles façons d’apprendre, de travailler, de penser, maîtrise de nouveaux modèles économiques, politiques et sociaux. Dans la civilisation de la connaissance, l’éducation devient plus essentielle que jamais : ce qui fut réalisé avec l’imprimé (alphabétisation) doit être repensé et réalisé avec l’Internet, nous donnant de bonnes méthodes pour assimiler les mutations rapides de notre milieu cognitif. Une éducation qui ne ressemblera pas aux précédentes.

L’information et la connaissance à l’ère numérique ont aussi des conséquences politiques. Ces biens immatériels dont la propriété est problématique est aujourd’hui source de nombreux conflits : les catégories politiques modernes (Etat-nation, démocratie, partis, parlements, … ) sont bouleversées par les réseaux numériques et leurs nouveaux modes d’expression, de socialisation et de partage : l’être-ensemble et le bien-commun vont muter. Ainsi, simple exemple parmi plein d’autres, une barbarie numérique se manifeste au travers de son utilisation par une économie militarisée et une criminalité institutionnalisée, du fait d’un pillage généralisé, comme par exemple au Congo, des minerais comme le coltan, essentiel aux smartphones, et le cobalt, pour les batteries électriques dans une perspective de transition énergétique.

« L’individu, qui est au centre des rapports de pouvoir après le déclin des grands collectifs (nations, classes), doit défendre son autonomie : la vie privée est une frontière spontanée entre les informations que nous partageons et ne partageons pas, et cette frontière doit être repensée à l’âge numérique. »

Le prix fort à payer pour un monde connecté, comme le souligne Fabrice Lebrun (5) . Tout cela dit, et à la différence de simples bombes, les outils numériques ont aussi des qualités et des avantages considérables. Comme ceux liés à l’utilisation de l’énergie nucléaire dans les centrales qui produisent de l’énergie ou dans certains traitements thérapeutiques ayant recours aux radiations.

Au menu d’un ouvrage de Vincent Held (6) , entre dystopies technologiques, manipulations médiatico-politiques et « Grande réinitialisation » économique, les populations occidentales, plus désorientées et fragilisées que jamais, ont bien des raisons de se demander à quelle sauce elles vont être mangées. Effondrement financier et monétaire, omni-surveillance numérique, ingénierie sociale et autres projets de rééducation idéologique sont au menu de cet ouvrage et, dans un autre (7) , à partir d’un faisceau d’informations soigneusement sourcées, l’auteur explique comment ces technologies doivent contribuer à imposer un « changement de culture » radical dans nos sociétés. Ceci en accord avec les orientations idéologiques impulsées par diverses institutions internationales telles que l’ONU, le Conseil de l’Europe, ou encore le Forum de Davos. Un livre qui évoque les tentations totalitaires d’une partie des élites occidentales. L’hyper-connexion entraîne souvent des problèmes de santé physique ou mentale ou de distanciation sociale, surtout chez les jeunes.

Sean Parker, un ancien dirigeant de Facebook, un jour déclara publiquement : « Dieu seul sait ce que nous sommes en train de faire avec le cerveau de nos enfants. La conception de la science comme savoir est mise à l’écart, voire ridiculisée. Ce qui n’est plus que de la technologie qui se fait passer pour de la science, tant à l’université que dans l’enseignement secondaire. La connaissance est réduite au triste statut « d’épiphénomène mental ». Ce qui était autrefois un savoir, produit par des hommes qui ont usé leurs neurones, brûlé leurs cils, volé leurs heures de sommeil et de loisir, est aujourd’hui « aspiré » par les pompes du Capital et transformé en force d’exploitation. »

Ainsi, pour Carlos X. Blanco, le savoir se meurt. Et seule à présent la technique, c’est-à- dire la transformation universelle en marchandise, règne en maître. L’homme lui-même est déjà une marchandise (8) : « Nous devons commencer à voir le Capital comme une pompe à vide, comme une ventouse aliénante qui fonctionne comme un transducteur : il convertit une modalité

énergétique (cognitive) en une autre (production via l’exploitation de la nature et de l’homme). » (…) « L’éducation numérisée, contre toute évidence scientifique, est extrêmement nocive pour les enfants et les mineurs. Ils deviennent techno-dépendants (surtout des téléphones portables), ce qui les détourne des contenus académiques qu’ils devraient acquérir sérieusement et rigoureusement pour devenir des personnes critiques et responsables. » (…)

L’addiction numérique

Yves Ponroy ne peut s’empêcher de rapprocher notre époque de celle, décrite de façon prophétique par Aldous Huxley dans « Le meilleur des mondes », qui annonce une civilisation séduite et gavée d’un torrent de contenus, rendue esclave et comme somnambule par le plaisir qu’elle s’inflige. L’information disponible est noyée dans un flot d’absurdités et la servitude aux divertissements s’est transformée en addiction (9) .

« C’est dire s’il est important d’éduquer nos enfants et de s’éduquer soi-même pour nous protéger de cette addiction qui ressemble fort à un esclavage. Internet est le plus beau des outils, il faut apprendre à s’en servir pour en rester le maitre. »

« Nous sommes passés (…) à une autre phase dans laquelle l’exploitation de la « matière grise » est dominante et se transforme en exploitation au second degré. » (…) « Le turbo-

capitalisme n’admet plus les « peuples », n’admet plus la « classe ouvrière », ne tolère plus le « savoir populaire ». Le capitalisme dans sa phase actuelle a besoin, en plus de travailleurs « formés », de consommateurs également « formés ». Les lois elles-mêmes cessent de parler de connaissances et se réfèrent à des compétences, des normes d’apprentissage et d’autres concepts stupides conçus pour des singes et non pour des enfants, membres de l’espèce humaine. »

Il y a bien d’autres questions, comme le surendettement croissant d’une partie de la population, stimulée par les outils numériques, poussant toujours plus à la consommation et aux emprunts (10) . Ou la question de l’e-commerce en terme de pression, notamment sur les commerces locaux et certaines délocalisations industrielles et le coût écologique exorbitant des centaines de millions d’objets emballés et livrés individuellement et le plus souvent avec des conditions de travail lamentables pour les livreurs ….

Et, bien sûr, la consommation énergétique des serveurs numériques et les émissions de carbone ou destructions forestières qui y sont associées. Le numérique représente aujourd’hui 3 à 4 % des émissions de gaz à effet de serre (GES) dans le monde (11) et 2,5 % de l’empreinte carbone nationale en France (12) .

Comme le souligne The Shift Project (13) , les nouvelles promesses de l’IA et de la puissance de calcul intensifiée ne sont pas compatibles a priori avec la transformation vers la décarbonation : demandes matérielles et énergétiques pour la production et l’utilisation des serveurs, centres de données, infrastructures, empreinte carbone des renouvellements de parcs d’ordinateurs, smartphones et objets connectés justifiés par « l’IA », etc. Prendre en compte la double contrainte carbone au bon niveau dans le numérique implique un changement de paradigme, et les infrastructures de données et de calculs ne font pas exception : la question des conditions de pertinence revient invariablement.

Quelle approche méthodologique choisir ? Quelles sont les conditions sous lesquelles l’adoption de l’intelligence artificielle engendrera des dynamiques carbone-énergie bénéfiques plutôt que délétères ? Et celles sous lesquelles le rythme de déploiement des centres de données ne fragilise pas la décarbonation de notre économie ? C’est ce que ce nouveau rapport du Shift visera à documenter, afin d’éclairer les trajectoires d’innovation et de déploiement pour les inscrire dans des trajectoires énergie, carbone et environnementales compatibles avec les contraintes physiques

La transformation numérique exerce aussi des effets majeurs sur des changements culturels, organisationnels, relationnels et les différentes formes de création de valeur publique qui en résultent, comme dans le domaine de la diffusion des œuvres littéraires ou musicales . Il s’agit ici aussi de repenser les processus et les services.

Pour certains auteurs, cependant, ce n’est pas le numérique l’esclavagiste, mais plutôt, notre propre manière de penser, de voir les choses et d’opter pour la technologie comme solution à nos problèmes, comme porte d’accès au réel. (…) C’est un acte consentant qui démontre une faiblesse accrue au niveau des mécanismes de défense face à la fascination par la technologie, cet artefact qui finit malheureusement par nous posséder ! (14)

Pour Dominique Pasquier, le numérique a profondément bouleversé le rapport à la culture et à la communication, et ce dans tous les milieux sociaux, en offrant notamment accès à une offre culturelle démultipliée (15). Mais les outils numériques ne sont pas porteurs d’ouverture culturelle en soi : le capital culturel du consommateur reste le facteur déterminant dans l’appropriation de cette offre. Dans une enquête sur l’appropriation d’Internet dans des foyers populaires de la France rurale, il a constaté que les usages de des nouveaux internautes étaient différents de ceux des populations diplômées qui s’étaient emparées d’Internet avant eux : le passage par l’écrit leur posant problème, ils échangent beaucoup à travers des images et des vidéos trouvées en ligne et optent pour les sites et les réseaux sociaux qui demandent le moins une écriture formelle. Ils créent peu de contenus sur Internet et la famille reste quand même au centre de leurs réseaux d’échange. Il se produit clairement une ouverture du côté du rapport au savoir, que ce soit à travers des recherches d’information sur la santé, le travail scolaire des enfants ou leur métier.

Les tutoriels marquent aussi une rupture en ouvrant vers de nouvelles manières de faire ou d’apprendre. Cette dimension d’internet comme « seconde école » mérite d’être creusée dans le cadre d’une réflexion sur la socialisation (16) . La conscience étant la capacité d’accéder à volonté à nos contenus mémorisés pour les « interpréter » plus ou moins objectivement, et donc « librement » et ainsi, pouvoir les partager.

Et c’est ce que mine précisément l’addiction aux contenus numérisés qui éteignent très souvent ces moments de création de lucidité personnelle et constructive. Cela particulièrement dans un contexte nourri par les discours dits « populistes », voire « dictatoristes » et leur dissémination grandissante via ces réseaux pseudo-sociaux. Et avec un contrôle numérique autoritaire qui, dans certains pays, pourrait bientôt être absolu et donc irréversible du point de vue social, sociétal et donc politique.

Pour Isabelle Filliozat, psychothérapeute, le corps est une machine à apprendre (17) . Si on installe l’immobilité, on n’apprend plus rien. Un enfant a besoin de grimper, sauter, courir plusieurs heures par jour. Elle explique que les écrans ne sont pas des jouets anodins que l’enfant mettra de côté quand il en sera lassé. Ce sont des produits addictifs. Sur un écran, le rythme soutenu des sollicitations visuelles et sonores excite le noyau accumbens de la région septale, impliquée dans le circuit du plaisir, de la récompense et de la dépendance. Le cerveau immature du tout-petit est incapable de réguler ces phénomènes : sous écran, l’enfant est « médusé » ; l’arrêt brutal de l’écran déclenche les circuits de la douleur : l’enfant hurle et devient incontrôlable.

Et Emmanuel Devouche(15) invite, alors à ne pas oublier qu’alors que le tout-petit présente une appétence sans limites pour le contact humain, l’écran ne communique pas comme une vraie personne, ne s’adapte pas aux besoins exprimés, n’amène pas de réponses…

Cela dit, comme l’exprime ici encore Carlos X Blanco, « aujourd’hui, le turbo-capitalisme s’emploie à creuser un fossé large et infranchissable entre la super-élite mondiale et une vaste masse non qualifiée, qui ne recevra même pas une formation élémentaire pour pouvoir utiliser (valoriser) sa force de travail. La masse sera socialisée par des appareils mobiles et toute une pléthore de dispositifs de contrôle bio-cybernétique. Il y aura un « profil » numérisé de chaque personne dans lequel les États, larbins de la super-élite mondiale, connaîtront à la perfection l’état de santé, sexuel, financier et consumériste de chaque individu. L’humanité sera réduite à un « parc » de loisirs, avec des entités zoologiques humaines, mais déshumanisées et numériquement dépendantes de l’enchevêtrement des fournisseurs d’applications. »

Le numérique et la démocratie

Si les outils numériques et systèmes d’IA doivent éviter de créer de nouvelles barrières, ils sont vulnérables aux abus et aux manipulations. Nombreux sont ceux qui affirment qu’à l’échelle à l’ère numérique certains de ces outils remettent en question la manière dont l’information est produite et distribuée avec peu de cohérence et de transparence.

Notamment par la publicité politique, une pratique dans le contexte d’un écosystème numérique plus large et n’exposant les personnes qu’à un seul point de vue (18). Reste à définir ce qui constitue réellement une publicité politique pour laquelle il n’existe encore aucune définition convenue, les plateformes de l’internet agissant selon leurs propres règles, avec peu ou pas de contrôle par des organismes indépendants. Ce qui peut mettre en péril les principes fondamentaux de la bonne gouvernance démocratique tels que la transparence, la responsabilité, l’intégration et le comportement éthique, ainsi que des droits tels que la protection de la vie privée et des données.

En raison du manque de données, il est impossible actuellement de répondre à la question de savoir si le micro-ciblage rend réellement les débats politiques opaques, polarisés et susceptibles d’être capturés par des intérêts étroits (groupes) ou, au contraire, apporte des informations personnalisées aux électeur/trices et aux citoyen(ne)s en général et contribuent ainsi à une action positive au discours démocratique. Des mesures doivent donc être prises pour minimiser ces risques par une transparence et une responsabilité respectant pleinement les exigences de protection des données et le droit à la vie privée.

Un exemple parmi d’autres est celui des désinformations au sujet du réchauffement climatique de la planète. Longtemps réfuté par les « climato-sceptiques » mais étant devenu une évidence, ceux-ci ont opté pour un autre argument qui est d’affirmer que l’humanité n’en n’est pas responsable et ceci notamment via d’innombrables avis sur les réseaux pseudo-sociaux.

Par ailleurs, une forme de cyber-démocratie ou démocratie numérique, s’est développée via l’utilisation de sites Internet comme supports des informations, de débats, voire des processus de décisions démocratiques. Elle cherche à répondre différemment à un idéal démocratique dans lequel tous les citoyens seraient des participants égaux aux propositions, aux créations et à la mise en œuvre des lois.

Cette forme numérique de démocratie semble davantage plaire à la jeunesse, et, face à l’accroissement des taux d’abstention, pourrait augmenter leurs prises de conscience politique et, donc, leur participation aux élections (19) . Cela mènerait-il aussi, par exemple, à des « assemblées et tribunaux populaires » élargissant la forme actuelles de « jury populaire » existant en cours d’Assises ? Une difficulté qui pourrait empêcher la matérialisation de cette évolution étant l’identification sécurisée des citoyens impliqués, comme dans le cas déjà des votes électroniques.

Un parti politique australien, Metagovernment Senator On-Line (Sénateurs en ligne), représenté aux élections fédérales de 2007, proposait un système de cyber-démocratie pour que les Australiens décident du choix du vote des sénateurs pour chaque projet de loi mais les intérêts en jeu dans le monde politique constituent un problème et ce projet ne semble pas avoir beaucoup avancé depuis, alors que, par ailleurs, une loi va bannir tout accès aux média sociaux aux jeunes de moins de 16 ans (20) .

Pour la sociologue américaine Jen Schradie (21) , l’ère de l’utopie numérique semble être sur sa fin. A l’avenir, les activistes de tous bords vont tenter de s’emparer du pouvoir d’internet pour promouvoir leur cause. Si la fracture présente dans l’activisme numérique continue à s’élargir, seules les voix de certains privilégiés pourront se faire entendre dans la nouvelle ère à venir. Un tel scénario signerait l’arrêt de mort du rêve technologique comme force de progrès, mais aussi de la possibilité d’une société réellement démocratique.

Quant aux idées elles-mêmes, les slogans conservateurs ou d’extrême droite sont en général plus provocateurs, ou en tout cas provoquent plus d’émotion, de colère dans les réactions sur les réseaux sociaux. Or les algorithmes adorent ce genre de contenus qui suscitent de l’engagement. À l’heure où l’activisme hashtag fait les gros titres, le cyber-militantisme radical s’avère redoutablement efficace. Il accélère et renforce les rapports de classe et la polarisation idéologique de nos sociétés (22) .

Dans ce contexte, le rapport du Conseil de l’Europe « Etude sur l’impact de la transformation numérique sur la démocratie et la bonne gouvernance » (23) exprime une préoccupation quant au manque de transparence et de responsabilité concernant la façon dont la propagande politique est diffusée et financée et il appelle à plus de recherche et un meilleur accès aux données, afin de pleinement comprendre l’impact du microciblage sur la formation de l’opinion publique. Même si, globalement, la technologie numérique permet d’améliorer la qualité de la démocratie en termes de responsabilité et de réactivité, le rapport souligne que la numérisation expose la démocratie à de nouveaux risques et influences, et l’administration publique à de nouvelles vulnérabilités aux mains d’acteurs privés et publics ambivalents voire hostiles, qu’il convient d’identifier et de maîtriser.

Les acteurs privés, en particulier les intermédiaires de l’internet et les plateformes de médias sociaux, jouent de plus en plus un rôle central dans la sphère publique, en tant que fournisseurs d’infrastructures, créateurs de contenu et diffuseurs. Les grandes entreprises technologiques jouent le rôle de gardien des accès, en filtrant les informations partagées sur les plateformes sociales, en les orientant vers des publics spécifiques et en ayant potentiellement une influence sur l’opinion publique, le débat politique et, finalement, les résultats électoraux. Pour que l’obligation de rendre des comptes fonctionne efficacement, les gouvernements doivent donc préciser comment et dans quelle mesure les systèmes d’IA sont utilisés dans les processus décisionnels et ils doivent être en mesure de rendre des comptes quant aux décisions.

Le micro-ciblage politique

Nombreux sont ceux qui affirment que l’agence et la formation indépendante d’opinions sont remises en question par l’utilisation manipulatrice de la publicité micro-ciblée, y compris la manière dont l’information politique est produite et distribuée à l’échelle à l’ère numérique, les personnes risquant de n’être exposées qu’à un seul point de vue. Le microciblage rend-t-il les débats politiques opaques, polarisés et susceptibles d’être capturés par des intérêts étroits (groupes), créant ainsi des conditions de concurrence inégales ? Ou, au contraire, le micro-ciblage peut-il apporter une contribution positive au discours démocratique, les partis pouvant se connecter plus efficacement avec leurs électeurs et les citoyens en général ?

Cela soulève des questions concernant la protection des principes fondamentaux de la bonne gouvernance démocratique tels que la transparence, la responsabilité, l’intégration et le comportement éthique, ainsi que des droits tels que la protection de la vie privée et des données. L’un des principaux défis consiste donc à définir ce qui constitue réellement une publicité politique. Il n’existe aucune définition convenue et les acteurs agissent avec peu ou pas de contrôle. Au final, peu de cohérence et de transparence sont de mise et il est impossible de répondre pleinement à cette question, en raison du manque de données empiriques ou de preuves. Il est nécessaire d’approfondir la recherche et surtout d’avoir accès aux données des partis politiques et

des intermédiaires et plateformes de l’internet.

D’une manière générale, les outils numériques de participation, y compris les systèmes d’IA, doivent éviter de créer de nouvelles barrières. Dans le même temps, ces outils sont vulnérables aux abus et aux manipulations. Des mesures doivent donc être prises pour minimiser ces risques en respectant pleinement les exigences de protection des données et le droit à la vie privée, ainsi que la transparence et la responsabilité.

Comment (mieux) maîtriser les dangers et les risques liés à la numérisation

Face à ces enjeux, comment affronter ces effets dévastateurs des bombes numériques qui, du fait de la différence avec les bombes nucléaires, ne font pas l’objet d’une politique globale de dissuasion de leur emplois et sont déjà massivement employées ? Une méthode consiste à recourir à une boussole qui distingue quatre pôles (24) :

a) identifier les dangers potentiels ;

b) en évaluer les risques réels ;

c) en déduire des niveaux de sécurité acceptables et réalistes ;

d) cela, en intégrant les avis des diverses parties prenantes.

Un niveau de risque acceptable (ce que l’on nomme le niveau assurant une sécurité) n’étant pas définissable par des critères « absolus », il doit être établi en intégrant systémiquement une série de critères permettant d’arbitrer entre avantages et inconvénients :

- culturelles ou éthiques ;

- effets « indésirables » ;

- capacités technologiques de maîtrise des risques;

- contraintes socio-économiques ;

- choix sociétaux et émotionnels ;

- contextes politiques ;

- …

Il faut se rendre compte que le niveau de sécurité est alors fonction de la perception du risque et de son acceptation ; et qu’une fois formée, une conviction relative à un degré d’acceptabilité est quasi impossible à changer. En effet, pour Yves Ponroy (25) , nous devenons volontiers le serviteur d’un chef, d’un maître à penser, d’une idéologie, d’une philosophie, d’une culture et d’une somme d’à-priori et de pensées toutes-faites qui nous entravent. Même celui qui se prétend « libre-penseur » est souvent l’esclave de ses croyances et de ses certitudes …

C’est à ce stade que les faits « scientifiques » doivent être fournis aux parties prenantes :

– exacts et strictement factuels ;

– validés par des pairs ;

– simplifiés dans un langage accessible au non-spécialistes.

Le « risque » d’un manque d’information factuelle pourrait mener à la répétition du syndrôme vécu avec les OGM : des amalgames réducteurs ayant tendance à exiger de le mettre « tous dans le même panier » ! Ce qui est, en soi, une démarche totalitaire et déraisonnable, ce genre de vision réductrice et dogmatique rendant beaucoup d’argumentaires irrecevables et indéfendables !

Cela dit, certains agents résistent encore à la capacité d’analyse complète de leurs dangers et risques et de leurs conséquences, comme par exemple les microplastiques, les perturbateurs endocriniens, ou … les outils numériques. C’est alors l’enjeu de la mise en œuvre d’un Principe de précaution (26) qui s’impose, mais, dans la pratique les mesures prises, doivent être proportionnées au risque envisagé dans les modalités de son application. Inscrit dans les textes, des lignes de conduite de l’UE recommandent explicitement de mettre en balance précaution et proportion (27) . Et dans la réalité, la maîtrise d’un risque implique aussi le plus souvent des mesures de prévention : des mesures anticipatives des risques qui permettent alors de bénéficier des avantages des applications de l’agent en cause, en limitant au maximum « acceptables » leurs inconvénients. Ce que doivent alors pouvoir assurer des Règles de Gouvernance réellement contrôlées dans leur application (28) .

Cela dit, pour les risques des outils numériques, les établir au « cas par cas » n’est pas plus réaliste qu’établir un impossible « moratoire global » à leur propos. Il importe donc d’anticiper et de préparer les « décideurs » à réglementer de façon plus élaborée entre prévention, précaution et proportion et à pouvoir communiquer, en particulier dans une situation de crise lié à des applications numériques, comme c’est le cas de la mise en évidence d’un risque grave : sanitaire, sociétal, environnemental, voire politique.

Conseil de l’Europe – Etude sur l’impact de la transformation numérique sur la démocratie et la bonne gouvernance

« Avec beaucoup de cuisiniers, vous pouvez servir un excellent buffet ! Notre travail est basé sur un concept simple et convaincant que nous appelons le principe « un pour tous ». Tout le monde cuisine quelque chose et nous pouvons ainsi tous profiter de la gamme complète de services numériques. Une approche entièrement collaborative, où chacun peut contribuer ce qu’il sait le mieux faire ! »

Markus RICHTER, Secrétaire d’Etat et Commissaire fédéral aux technologies de l’information, Allemagne

En ces temps difficiles pour le Conseil de l’Europe, la capacité à passer au numérique a grandement contribué à la résilience de l’action publique, permettant aux institutions démocratiques de continuer à fonctionner et aux services publics d’être fournis. En parallèle, cependant, la numérisation expose la démocratie et l’administration publique à de nouvelles vulnérabilités aux mains d’acteurs privés et publics malveillants. La plupart des Etats membres soulignent la nécessité d’inscrire fermement la conception, le développement et le déploiement de l’IA dans un cadre éthique. Les valeurs et principes fréquemment mentionnés dans ce contexte sont l’approche centrée sur l’homme, une IA fiable et responsable, la transparence et la surveillance humaine.

Si tous les Etats membres mentionnent un cadre éthique, certains soulignent aussi spécifiquement la nécessité de réglementer l’IA et de voir le secteur public jouer le rôle de régulateur. Comme mentionné ci-dessus, au Conseil de l’Europe, le Comité ad hoc sur l’intelligence artificielle (CAHAI) a publié une étude de faisabilité examinant si et comment l’IA pourrait être réglementée et travaille actuellement à l’élaboration d’éléments pour une éventuelle réglementation.

L’une des principales préoccupations concernant l’utilisation de systèmes de décision automatisée est ce que l’on appelle l’effet de boîte noire. Ces systèmes reposent souvent sur des algorithmes. L’algorithme parcourt les données et donne un résultat. Cependant, parfois, ni les programmeurs, ni les fonctionnaires ne peuvent expliquer comment ou pourquoi l’algorithme est arrivé à ce résultat particulier. Le raisonnement et la prise de décision se font donc dans une boîte noire. L’effet boîte noire s’oppose clairement aux normes publiques établies, telles que la transparence, l’explicabilité et la responsabilité. En outre, les algorithmes sont souvent développés par des sociétés privées et déclarés secrets commerciaux ; ils ne sont donc pas soumis à l’examen critique du public ou à l’évaluation par les pairs. Le manque d’informations sur le fonctionnement de ces systèmes rend difficile la correction de la conception et l’établissement des responsabilités, ici encore entre précaution et proportion.

Et, sous la pression de Donald Trump et Elon Musk, tous les grands réseaux américains comme X, et à présent ceux de Meta contrôlés par Mark Zûckerberg : Facebook, Instagram, … viennent de décider d’abandonner toute forme de contrôle crédible de leur contenu (« fact-checking »).

La Réglementation européenne des pratiques numériques

En ce qui concerne un contrôle de la diffusion de contenus illicites et leurs dommages « sociétaux », les très grands moteurs de recherche et les plateformes numériques en ligne présentant des risques particuliers, l’Union européenne est sans doute la plus avancée. Des règles d’usage spécifiques ont été adoptées, notamment dans l’Union européenne pour les plateformes qui touchent plus de 10 % de ses 450 millions de consommateurs. Cela depuis le 17 février 2024 dans le cadre de la législation Regulation on Digital Services Act sur les services numériques adoptée le 27 octobre 2022 (29). Cet AI Act est, de fait, la première loi au monde en matière d’intelligence artificielle adoptée à l’unanimité par les 27 États membres de l’Union européenne et marquant une étape clé dans la régulation de l’intelligence artificielle. Si l’AI Act répond à un enjeu majeur en matière de transparence et d’éthique, il crée des obligations conséquentes supplémentaires pour toutes les entreprises qui utilisent ou développent de l’intelligence artificielle.

Les principaux changements apportés par l’application de la nouvelle législation européenne sur les services numériques couvrent notamment :

- des moyens simples et clairs de signaler des contenus, des biens ou des services illégaux sur les plateformes en ligne ;

- des obligations de diligence pour les plateformes et des obligations renforcées pour les très grandes plateformes, sur lesquelles se produisent les irrégularités les plus graves ;

- des autorités mieux armées pour protéger les citoyens en surveillant les plateformes et en veillant ensemble à l’application des règles au sein de l’Union ;

- des obligations renforcées pour les très grandes plateformes en ligne d’évaluer et d’atténuer les risques au niveau de l’organisation globale de leur service lorsque les restrictions des droits et les risques de diffusion virale de contenus illicites ou préjudiciables ont des répercussions très importantes ;

- Les utilisateurs seront informés de la suppression de contenus par les plateformes et pourront la contester ;

- Les utilisateurs auront accès aux mécanismes de règlement des litiges dans leur propre pays.

Des mesures de gestion des risques appropriées et ciblées pour répondre aux risques identifiés vont jusqu’à l’enregistrement dans la base de données de l’UE en passant par la traçabilité, la supervision humaine, ou encore l’exactitude, la robustesse et la sécurité du système d’IA tout au long de son cycle de vie.

Ces règles s’appliquent donc à présent à l’ensemble des intermédiaires et plateformes en ligne tels que les places de marché, les réseaux sociaux, les plateformes de partage de contenus, les boutiques d’applications et les plateformes de voyage et d’hébergement en ligne (30) . En établissant des règles claires et proportionnées, elles sont censées mieux garantir la sécurité des utilisateurs et leurs droits fondamentaux en ligne, tout en créant un environnement équitable et ouvert pour les plateformes en ligne. Leur principal objectif étant de prévenir les activités illégales et préjudiciables en ligne et la propagation de la désinformation.

Les modèles d’IA génératives, incluant notamment Mistral, ChatGPT ou Bard, conçus hors UE, vont aussi devoir se mettre en conformité, qu’ils soient open source ou ne le soient pas. Avec, notamment, plus de transparence en ce qui concerne les décisions relatives à la modération des contenus grâce à la base de données sur la transparence des services numériques (31) , cette législation devrait donc aussi favoriser l’innovation, la croissance et la compétitivité et faciliter l’expansion des plateformes de plus petite taille, des PME et des jeunes entreprises. Mais certains pensent au contraire que les obligations conséquentes pour toutes les entreprises qui utilisent ou développent de l’intelligence artificielle, malgré quelques aménagements prévus pour les startups et PME, pourraient en fait particulièrement profiter à la concurrence américaine et chinoise et réduire les opportunités de faire émerger des champions européens de l’IA (32) .

Les rôles des utilisateurs, des plateformes et des pouvoirs publics sont ainsi (ré)équilibrés conformément aux valeurs européennes, en plaçant les citoyens au centre des préoccupations.

La surveillance de l’I.A.

Encore faut-il que l’application et le suivi de cette législation soit bien relayée et mise en application par l’ensemble des pays de l’Union européenne et il serait indispensable qu’elle le soit bien au-delà … Paradoxalement, Le CEPD (Contrôleur européen de la protection des données) a publié une décision constatant que la Commission européenne elle-même a, durant un moment, illégalement ciblé la publicité sur les citoyens en utilisant des données personnelles « sensibles » sur leurs opinions politiques (33) ! Le CEPD n’a émis qu’un blâme puisque la Commission européenne a mis fin à la pratique.

La question du contrôle démocratique des systèmes d’IA reste en effet pertinente et, jusqu’à présent, peu d’organisations de la société civile agissent en tant que veilleurs ou gardiens de l’IA. Par exemple, AlgorithmWatch (34) est une organisation de recherche et de défense à but non lucratif qui se consacre à l’évaluation et à la mise en lumière des processus décisionnels algorithmiques qui ont une pertinence sociale, c’est -à-dire qu’ils sont utilisés soit pour prédire ou prescrire l’action humaine, soit pour prendre des décisions de manière automatique. Afin de mieux garantir que les systèmes de décision automatisée (SDA) actuellement déployés et ceux sur le point d’être mis en œuvre dans toute l’Europe sont conformes aux droits de l’homme et à la démocratie, AlgorithWatch recommande entre autres :

– d’établir des registres publics pour les systèmes SDA utilisés dans le secteur public ;

– de développer et d’établir des approches pour vérifier efficacement les systèmes algorithmiques ;

– de promouvoir un débat démocratique inclusif et diversifié autour des systèmes SDA.

La période actuelle de transformation numérique se concentre sur la refonte des processus administratifs existants avec une attitude de type « le numérique d’abord » : tous les services sont principalement conçus pour servir le public en ligne. La fourniture de services hors ligne ou analogiques est devenue une seconde priorité. Des approches de conception centrées sur l’utilisateur doivent pouvoir aider les fonctionnaires à comprendre les besoins de leurs utilisateurs et leur permettre ainsi de concevoir des services et des produits numériques qui sont basés sur ces besoins externes, plutôt que sur la seule logique interne des administrations publiques.

Actuellement, 53 % des pays de l’OCDE seulement ont des exigences formelles pour l’utilisation éthique de l’IA des algorithmes par les institutions du secteur public. (par exemple via des lois ou des règlements). Dans ce contexte, l’indice de l’OCDE sur l’administration numérique (DGI) évalue les efforts déployés par les gouvernements pour établir les bases nécessaires à la transformation numérique du secteur public (35) . Il évalue notamment la maturité de l’administration numérique et couvre six dimensions : 1 Numérique par conception, 2. Orienté vers les données, 3. Gouvernement en tant que plateforme, 4. Ouvert par défaut, 5. Orienté vers l’utilisateur et 6. Proactivité.

Brève conclusion et perspective(s)

Un des principaux garde-fous contre les dérives irréversibles, individuelles et collectives d’une numérisation incontrôlée, sinon incontrôlable, reste une véritable éducation humaine, permanente et dédiée, une attention constante aux acquis, un accompagnement et une stricte éthique.

Ce n’est pas juste une hypothétique maîtrise d’outils comme on maîtrise un aspirateur. Apprendre concrètement, en particulier aux enfants en bas âge mais aussi à l’ensemble des citoyen(ne)s, comment vivre et se positionner en maîtrisant l’envahissement de ces outils et de leurs vices et dérives.

Ce qui n’empêche pas bien sûr de renforcer au niveau national et international les réglementations concernant les contenus, l’accessibilité et la circulation des outils internet et d’en renforcer les moyens effectifs de contrôle d’intervention et de sanction, voire de suppression.

L’histoire nous enseigne que chaque avancée technologique majeure s’accompagne de bouleversements profonds, parfois imprévus. À l’instar de la bombe atomique, qui a redéfini les équilibres politiques et stratégiques mondiaux, le numérique et l’intelligence artificielle exercent déjà des impacts significatifs sur nos sociétés, nos économies et nos relations internationales. L’IA, en particulier, devient un enjeu géopolitique majeur, offrant un avantage stratégique à ceux qui maîtrisent ses développements les plus avancés. Mais cette quête effrénée de domination technologique pose des questions éthiques cruciales.

Le numérique, tout comme l’arme nucléaire en son temps, nous invite à réfléchir à l’usage que nous faisons de nos découvertes et à l’impact qu’elles peuvent avoir sur nos libertés, nos institutions, et même notre humanité. Alors que les transformations s’accélèrent, il est impératif de tirer les leçons du passé, de mettre en place des cadres de régulation responsables et d’agir avec la prudence et la sagesse nécessaires pour préserver un avenir équilibré et durable. La technologie est un outil puissant, mais elle exige une gouvernance éclairée pour qu’elle demeure au service de l’humanité, et non l’inverse.

Jacques de Gerlache (1), Eco-toxicologue, professeur à l’institut Paul-Lambin à Bruxelles. Conseiller scientifique auprès du Conseil fédéral belge du développement durable. Manager du site www.greenfacts.org

(1) Avec la collaboration active de Pierre Coërs

(2) Voir notamment « Barbarie numérique. Une autre histoire du monde connecté » aux éditions L’Echappée, Fabien Lebrun

(3) https://www.grasset.fr/livre/la-civilisation-du-poisson-rouge-9782246819295/

(4) Benoit Sillard. https://www.eyrolles.com/Informatique/Livre/maitres-ou-esclaves-du-numerique–9782212551495/

(5) https://www.lechappee.org/collections/pour-en-finir-avec/barbarie-numerique

(6) Vincent Held -Asservissement – De la déshumanisation sociétale à l'esclavage numérique

https://www.libeurop.eu/fr_FR/shop/product/9782970126249-asservissement-de-la-deshumanisation-societale-a-l-esclavage-numerique-661004

(7) https://www.moliere.com/fr/held-vincent-3b-deheuvels-paul-une-civilisation-en-crise-l-occident-a-l-epreuve-de-l-intelligence-artificielle-9782970126232.html srsltid=AfmBOorBdKgwxO_9jjLSOcuCn-kPGGvVV8_BvOaRNtyfgNdf1pGtrk4S

(8) https://www.geopolitika.ru/fr/article/la-numerisation-de-leducation-et-de-la-connaissance-un-vol-au-detriment-des-citoyens

(9) https://www.geopolitika.ru/fr/article/la-numerisation-de-leducation-et-de-la-connaissance-un-vol-au-detriment-des-citoyens

(10) Directive (UE) 2023/2225 du Parlement européen et du Conseil du 18 octobre 2023 relative aux contrats de crédit aux consommateurs. https://eur-lex.europa.eu/legal-content/FR/TXT/PDF/?uri=OJ:L_202302225

(11) https://www.greenit.fr/empreinte-environnementale-du-numerique-mondial/

(12) https://www.arcep.fr/la-regulation/grands-dossiers-thematiques-transverses/lempreinteenvironnementale-du-numerique/etude-ademe-arcep-empreinte-environnemental-numerique-2020-2030-2050.html

(13) The Shift Project – https://theshiftproject.org/en/home/ Lancement du projet Intelligence artificielle : quelles infrastructures dans un monde décarboné ? https://theshiftproject.org/wp-content/uploads/2023/05/Note-danalyse_Planifier-la-decarbonation-du-systeme-numerique-en-France_Mai2023.pdf

(14) Ce que l’on possède finit par nous posséder ! esclavage numérique. Khalil Jelassi. La Presse Magazine N° 1782 -11 septembre 2022. https://lapresse.tn/wpcontent/uploads/2022/09/mag1109_merged_compressed.pdf

(15) https://www.centrepompidou.fr/fr/magazine/article/numerique-inegalites-culturelles-les-nouveaux-enjeux-de-la-socialisation-des-enfants

(16) L’Internet des familles modestes, Presses des Mines, 2018.

(17) https://www.fondationmustela.com/fr/informer-pour-sensibiliser/le-developpement-de-lenfant-lere-du-numerique

(18) https://www.europarl.europa.eu/topics/fr/article/20230202STO71504/l-importance-des-nouvelles-regles-de-l-ue-en-matiere-de-publicite-politique

(19) Frank Esser et Claes H. de Vreese, « Comparing Young Voters' Political Engagement in the United States and Europe », American Behavioral Scientist, vol. 50, 2007, p. 1195–1213 DOI 10.1177/0002764207299364

(20) https://www.aph.gov.au/Parliamentary_Business/Committees/Senate/Environment_and_Communications/SocialMediaMinimumAge

(21) Jen Schradie. L'illusion de la démocratie numérique. Internet est-il de droite ?

https://www.sciencespo.fr/osc/en/node/2371.html

(22) https://www.humanite.fr/politique/algorithmes/jen-schradie-les-algorithmes-adorent-les-contenus-dextreme-droite-743389

(23) https://rm.coe.int/etude-sur-l-impact-de-la-transformation-numerique-sur-la-democratie-et/1680a3b9fa

(24) https://chimienouvelle.be/CN127/Article%20Gerlache.pdf

(25) https://chronique-libre.com/2024/08/10/1046-la-servitude-numerique/

(26) “Lorsque des éléments suffisamment étayés suggèrent qu’une activité est sérieusement soupçonnée de pouvoir causer des dommages irréversibles à l’environnement ou à la santé, des mesures doivent être prises, même si la preuve scientifique ultime ou le lien causal n’est pas encore formellement établi avec certitude”

(27) Le principe de précaution -Significations et conséquences -https://www.editions-ulb.be/fr/book/?GCOI=74530100507240

(28) https://afscet.asso.fr/Ande23/JdG-Constitutionalisation-gouvernance-controle_slides.pdf

(29) Regulation (EU) 2022/2065 of the European Parliament and of the Council of 19 October 2022 on a Single Market For Digital Services and amending Directive 2000/31/EC

https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX%3A32022R2065 et

https://eur-lex.europa.eu/resource.html?uri=cellar:e0649735-a372-11eb-9585-01aa75ed71a1.0020.02/DOC_1&format=PDF

(30) https://commission.europa.eu/strategy-and-policy/priorities-2019-2024/europe-fit-digital-age/digital-services-act_fr

(31 )https://www.vudailleurs.com/la-commission-lance-une-nouvelle-base-de-donnees-pour-suivre-les-conditions-generales-applicables-aux-services-numeriques/

(32) Marianne Tordeux Bitker, directrice des affaires publiques de France Digitale. https://francedigitale.org/publications/ai-act-guide-mise-en-conformite

(33) https://noyb.eu/fr/political-microtargeting-eu-commission-illegal

(34) https://algorithmwatch.org/en/

(35) https://www.oecd.org/fr/topics/policy-issues/digital-government.html

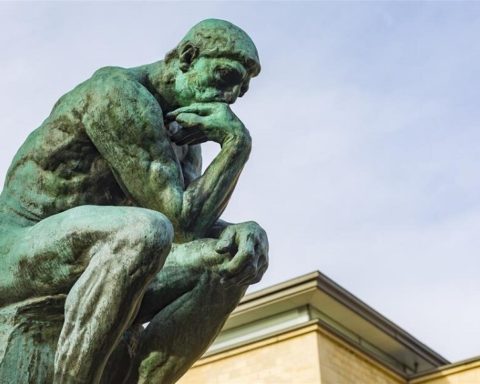

Photo d’en-tête : Montage à partir de l’oeuvre de Bruce Conner, « BOMBHEAD », 2002, impression numérique avec ajouts de peinture acrylique, MOMA © Conner Family Trust, San Francisco – ADAGP 2024 – photo Courtesy Magnolia Editions, Oakland, CA.

Pour aller plus loin :

- Géopolitique du numérique / L’impérialisme à pas de géants – Revue Futuribles, octobre 2023

- Article « Depuis la bombe atomique, l’éthique s’impose à tous les chercheurs« , Cédric Villani – La Tribune, 2018