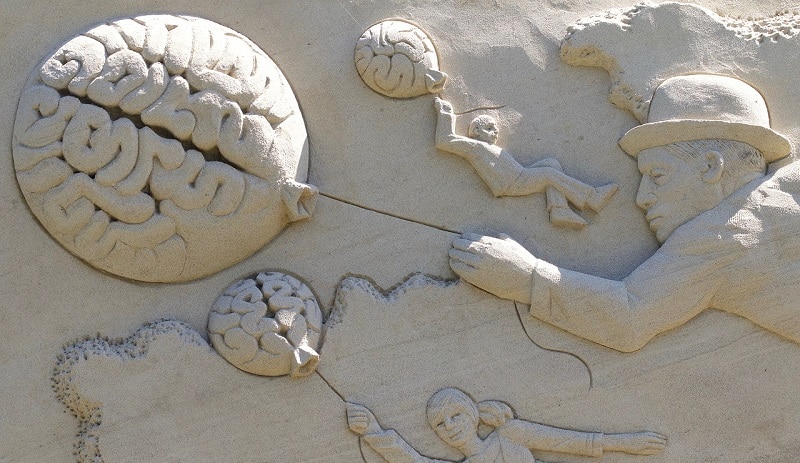

Intelligence artificielle du 3ème typeL’intelligence peut se définir selon deux grandes catégories de facultés. La première intelligence, que nous partageons avec la plupart des espèces animales, est celle qui nous relie au monde extérieur et nous permet de percevoir, d’apprendre, de reconnaître, d’estimer et de décider. Elle est centrale à notre capacité d’adaptation et de survie dans un monde toujours fluctuant et son automatisation a été jusqu’ici le principal moteur de l’Intelligence Artificielle (IA).Grâce aux progrès constants de la microélectronique, de l’informatique, du traitement du signal, de l’analyse statistique et plus récemment de l’apprentissage profond opérant sur de vastes données, des résultats remarquables ont été obtenus dans l’automatisation des tâches de perception et de décision. Un exemple saisissant de cette IA du premier type en est la voiture autonome dont on ne mettra pas en doute la virtuosité dans son respect des règles de conduite et dans son attention pour les autres.La seconde intelligence est ailleurs et est propre à chaque individu. Elle englobe les facultés de l’esprit, celles qui nous permettent d’imaginer, d’élaborer, d’inventer et d’espérer. Le seul modèle dont nous disposons pour essayer de reproduire dans une machine les propriétés de cette intelligence créatrice est notre cerveau, dont l’architecture est nettement différente de celle de l’ordinateur classique. Information et processus s’y entremêlent dans un même écheveau de connexions synaptiques, lesquelles se comptent en milliers de milliards.L’IA du deuxième type ne pourra pas faire l’économie de ce parallélisme massif qui pourra cependant et fort heureusement être décomposé à la façon des modules corticaux. Quand les mystères de l’information mentale et de l’organisation corticale auront été complètement levés, dès lors aussi que la microélectronique saura offrir les moyens de contrôler un grand nombre de connexions (disons quelques centaines de millions par module, pas plus), rien n’empêchera de concevoir des cortex artificiels avec plus de modules que n’en contiennent nos cerveaux. Cette IA du troisième type, que certains appellent singularité technologique, sera l’aboutissement d’une alliance détonante entre les neurosciences, l’électronique, le calcul intensif, la datamasse et le principe de diversité.Claude Berrou, Professeur à Télécom Bretagne

Naissance de l’Intelligence Artificielle

« Question : Vous semblez alors dire que les programmes IA seront quasi identiques aux humains. N’y aura-t-il aucune différence ?Réponse : Les différences entre les programmes IA et les humains seront probablement plus grandes que les différences entre la plupart des gens. Il est impensable que le « corps » contenant un programme IA ne l’affecte pas profondément. C’est pourquoi, à moins que son corps ne soit une réplique étonnamment fidèle du corps humain, (et pourquoi le serait-il ?), il aurait probablement des vues extrêmement différentes de ce qui est important, de ce qui est intéressant, etc. […] Je pense qu’un programme IA, même si nous pouvions le comprendre, nous paraîtrait assez étrange. C’est d’ailleurs pour cela que le moment où nous aurons affaire à un programme IA, et non pas à un programme simplement « bizarre », nous donnera beaucoup de fil à retordre. »Douglas Hofstadter, Gödel Escher Bach, 1985

LIRE AUSSI DANS UP’ : Elon Musk : vous me prenez pour un dingue ?

Il est temps de prendre l’Intelligence Artificielle au sérieux

60 ans d’intelligence artificielle. C’est en août 1956, lors de la conférence de Dartmouth, que l’expression « Artificial Intelligence » fait son apparition publique pour la première fois. Elle avait été utilisée par les pionniers John McCarthy, Marvin L. Minsky, Nathaniel Rochester et Claude E. Shannon l’été précédent pour proposer ce séminaire. Elle caractérise « la possibilité de produire des programmes qui se conduiraient ou penseraient intelligemment ». Ses ambitions d’alors, et le défi originel de l’Intelligence Artificielle, sont de « chercher à produire, sur un ordinateur, un ensemble de sorties qui serait considéré comme intelligent s’il était produit par un être humain ». L’IA peut se révéler à travers des simulations exactes des processus cognitifs humains, ou bien via des programmes conduisant à des conséquences intelligentes. Elle a été traversée par de nombreuses dualités, entre l’inné et l’acquis, entre les symboles des systèmes experts et les sous-symboles des réseaux de neurones formels, entre la compétence et la performance, qui ont rythmé son histoire. Technologie de la connaissance (nouvelle science de l’ingénieur) mais aussi science générale du traitement de l’information (par l’homme ou par la machine) ou encore théorie de l’homme et des processus cognitifs, cette discipline a eu tour à tour chacune de ces ambitions, ni incompatibles, ni indépendantes. Reliée intimement à un ensemble d’autres disciplines au sein des Sciences Cognitives, elle a eu en 60 ans ses moments de gloire mais aussi ses moments de doute et de recul. Ce sont les AI Winters que Yann LeCun, aujourd’hui responsable des équipes IA au sein de Facebook, et dont les travaux depuis 30 ans ont mené aux avancées spectaculaires d’aujourd’hui, n’hésite jamais à rappeler pour modérer certains enthousiasmes actuels vis-à- vis du large public. Mais parmi les chercheurs, nombreux sont ceux qui estiment, comme John Giannandrea, vice-président de l’ingénierie chez Google et responsable de l’activité machine learning, que « les choses sont en train de prendre une tournure incroyable » et que nous assistons à un véritable AI spring.

Qu’est-ce que l’intelligence ?

Ai-je affaire à un être humain ? La question de savoir si les dialogues qu’on exerce à travers une machine sont le fait d’êtres humains qui nous font face, ou bien de robots algorithmiques, ou d’une combinaison des deux, se fait de plus en plus prégnante avec le déploiement des services associés aux messageries instantannées comme Messenger de Facebook, et aux plates-formes de micro- blogging comme Twitter : les bots. L’enjeu est important, car il ne s’agit pas moins de capter les utilisateurs qui passent de plus en plus de temps sur ces outils, et de leur proposer à travers des dialogues intelligents une nouvelle manière d’accéder à l’information et à la consommation. C’est en quelque sorte une architecture nouvelle pour un navigateur internet à l’heure de l’IA, avec comme objectif de simplifier l’interaction avec les services en ligne. Le site d’information Quartz a ainsi déployé en février 2016 un bot avec lequel le lecteur dialogue, plutôt que consulter une longue liste d’articles, afin de se voir proposer des résumés des informations essentielles qui l’intéressent. Suivant Telegram et Kik, Facebook ouvre en avril 2016 son botstore sur Messenger. Pour la plupart, les 900 millions d’utilisateurs mensuels de Messenger pourront y croiser leurs premiers robots conversationnels, à condition que ceux-ci sachent ne pas être trop envahissants et rendent effectivement service. Il faut en effet que l’expérience utilisateur soit parfaite pour que l’adoption soit au rendez- vous. Un bot qui réserverait des billets d’avion sans tenir compte des temps de débarquement et d’embarquement et de contrôle lors des escales serait plus encombrant qu’utile, et desservirait la marque qui le diffuserait. Ces bots, développés pour assister les humains dans des tâches qui leur sont propres, doivent acquérir à terme des connaissances du niveau d’une IA forte, générale (voir ci-dessus), et une personnalité capable de s’adapter à chaque utilisateur, en prenant en compte ses habitudes, sa culture, ses croyances… C’est pourquoi pendant quelques temps encore les bots seront probablement toujours constitués d’équipes mixtes IA & humains. Saura-t-on toujours distinguer la part du bot de celle de l’humain ? http://botpoet.com/ invite à se tester dans un cas particulier : trouver qui d’un humain ou d’une IA a composé un poème.

60 ans de liens entre jeux et IA. Dès 1956, l’IA s’intéresse aux jeux comme source de défis. Arthur Samuel développe un premier programme de jeu de dames qui se forme par apprentissage par renforcement, et bat en 1962 un amateur américain de bon niveau, sur un seul jeu, devenant ainsi la première machine qui bat l’homme de l’histoire. Le jeu de backgammon suit en 1979, avec les mêmes techniques qui font jouer le programme contre lui-même pendant son apprentissage. Il atteint ainsi des niveaux qui sont réputés ne pas pouvoir être enseignés par des humains, tandis que ces derniers apprennent beaucoup en observant les capacités de ces programmes. C’est ainsi que l’on prend conscience que les intelligences artificielles pourraient bien servir à renforcer les intelligences humaines. Et c’est le jeu d’échecs, un jeu dont Claude Shannon avait dit dès 1950 qu’il consistait un bon défi pour la pensée mécanisée, qui tient en haleine chercheurs et joueurs jusqu’en 1997, quand l’ordinateur DeepBlue d’IBM bat le champion mondial Garry Kasparov. Et enfin le jeu de go en 2016, grâce à des techniques d’apprentissage profond, et un système ayant joué des milliers de parties contre lui-même, tombe à son tour. Mais il y a encore beaucoup à apprendre du jeu. Jusqu’à présent, les joueurs ont en effet une connaissance parfaite de tous les éléments du jeu. Il faut maintenant s’intéresser à des jeux à connaissance incomplète, comme le jeu de poker qui devient la prochaine étape à franchir. D’autres types de jeux, comme les robots footballeurs ou les voitures de course autonomes, présentent également de nombreux défis d’IA à relever, beaucoup plus généraux. Le jeu ultime reste ce que Alan Turing appelle en 1950 The imitation game. À l’origine une femme et un homme sont interrogés par une personne (homme ou femme) qui ne les voit pas, et qui doit deviner qui est la femme. L’homme caché doit donc imiter un « comportement féminin ». Turing se demande si un programme pourrait prendre la place de l’homme caché et leurrer l’interrogateur. Aujourd’hui, la question est de savoir quelle proportion d’humains perdrait à ce jeu.

Un modèle de l’architecture de l’esprit humain. Le General Problem Solver, créé en 1959 par Simon, Shaw et Newell, est une première tentative d’un système artificiel à l’heure de l’IA naissante, proposé pour résoudre n’importe quel problème, en confrontant les objectifs poursuivis et les moyens pour y parvenir. Ce système, qui a eu une grande influence sur l’évolution de l’Intelligence Artificielle et des Sciences Cognitives, résolvait très bien des problèmes simples, mais était limité dès lors que la combinatoire du problème augmentait. Ces travaux, et le livre de Newell & Simon, Human Problem Solving (1972), sont fondateurs du paradigme cognitiviste.

Evaluer l’intelligence

Quelles directions pour l’intelligence artificielle ?

Un quotidien bercé d’Intelligences Artificielles

L’avènement de l’apprentissage machine

À Télécom ParisTech, Albert Biffet mène des recherches dans le cadre du machine learning on real time. Il s’agit de fouiller des données (datastream mining) arrivant à haute vélocité. Cela peut être par exemple des flux de données de télécommunications. Aucune donnée n’est stockée et il faut s’adapter aux changements en temps réel. Les enjeux actuels sont de permettre du machine learning de ce type dans le cadre de l’Internet des objets, notamment pour permettre à ces objets de prendre de meilleures décisions. Un équilibre est recherché entre avoir plus de données à disposition ou avoir de meilleurs algorithmes pour prendre ces décisions sous contrainte de temps réel. Dans certains cas les flux de données étudiées arrivent de manière distribuée. Quatre types d’algorithmes sont retenus : classification, regression, clustering, et frequent pattern mining. Albert Biffet développe la prochaine génération de modèles et d’algorithmes pour fouiller les données en provenance de ces objets : des algorithmes qui ne cessent jamais d’apprendre, des algorithmes parallèles et distribués sur plusieurs machines, et enfin l’application de l’apprentissage profond à ces flux de données. Ces recherches bénéficient de l’existence de la chaire Machine Learning for Big Data à Télé- com ParisTech, pilotée par Stephan Clémençon, et dont les travaux ont déjà été traités dans le cahier de veille Big Data. Créée en septembre 2013 avec le soutien de la Fondation Télécom, et financée par quatre entreprises partenaires (Safran, PSA Peugeot Citroën, Criteo et BNP Paribas), la chaire produit une recherche mé- thodologique répondant au défi que constitue l’analyse statistique des données massives.

À Télécom Bretagne, Mai Nguyen élabore des robots adaptatifs, dans le cadre des services d’aide à la personne. L’apprentissage étudié est par exemple l’apprentissage actif par curiosité artificielle. C’est ce que fait un enfant entre 0 et 6 ans qui ne va pas à l’école, et pourtant apprend à se développer. Il joue, en autonomie. C’est l’enfant qui décide, parmi tous les jeux possibles. Les psychologues disent que l’enfant va choisir de manière intuitive la tâche qui va lui permetttre d’apprendre le plus. Chaque enfant a envie de faire des progrès, à sa juste mesure, et choisit des choses à apprendre pour le bien qu’il en tire lui-même. Il dispose pour cela de différentes stratégies d’apprentissage à disposition, par guidage social, ou en autonomie. C’est en s’inspirant de ces observations que la chercheuse imagine des robots capables d’apprendre de leur environnement physique.

LIRE AUSSI DANS UP’ : Convocation de la pyschanalyse dans le monde de l’intelligence artificielle

Vers une informatique neuro-inspirée

À Télécom Bretagne, Claude Berrou et son équipe cherchent au sein du projet européen Neucod (Neural Coding) à modéliser le cerveau humain par une approche jusque-là inédite : la théorie de l’information. Ils partent du constat que le néocortex, ce « milieu de propagation qui permet à des processus biologiques de passer d’îlots de connaissances à d’autres », possède une structure très proche de celle des décodeurs modernes. Leurs travaux ont permis de développer des codes de représentation et de mémorisation de l’information expliquant sa robustesse et sa pérennité. Tout démarre d’une analogie entre la théorie de l’information de Shannon et le cerveau humain. Cette analogie a permis le développement de mémoires associatives robustes et à grande diversité d’apprentissage, grâce aux travaux de Vincent Gripon. Elle prend en compte un monde qui est réel, riche, complexe, et surtout analogique. La phase de perception revient à du codage de source (enlever la redondance de l’environnement), et celle de mémorisation à du codage de canal (rajouter de la redondance pour rendre le signal plus robuste).