Nous n’avons pas besoin de regarder trop loin en arrière pour comprendre la puissance de la technologie à façonner notre monde. En une génération, nous avons vu des stations spatiales se construire, le calcul des vitesses s’accélérer de façon exponentielle, sans parler du boom d’Internet. En fait, les progrès technologiques sont désormais si rapides que notre mode de vie actuel paraîtra sans doute désespérément obsolète dans une autre décennie. Dans cet esprit, il peut être amusant et fascinant de regarder ce que sera l’avenir et quelles sont les technologies de pointe développées aujourd’hui qui seont d’une totale banalité demain. De quelles manières ces technologies modifieront-elles radicalement notre monde ? Bryan Nelson a écrit un papier dans revmodo.com, à partir duquel UP’ a enquêté sur la faisabilité et la réalité de neuf technologies qui pouraient bientôt faire que notre réalité devienne méconnaissable.

– L’énergie atmosphérique

– L’énergie atmosphérique

Credit photo : ©gornjak/Shutterstock

La plupart de l’énergie que nous produisons aujourd’hui provient de ressources limitées, à savoir les combustibles fossiles. Mais comme ces ressources sont épuisées et que les conséquences environnementales deviennent une préoccupation croissante, le développement de nouvelles sources d’énergie renouvelables est primordiale. Bien sûr, les industries telles que l’énergie éolienne, solaire et biocarburants sont déjà en plein essor, mais ce ne sont que le dessus de l’iceberg.

Une source renouvelable en plein essor qui a le pouvoir de révolutionner la production d’électricité est l’énergie atmosphérique. Il y a toujours en circulation libre de l’électricité dans l’air. Cela est particulièrement évident dans un orage ou pendant les aurores polaires ou les aurores boréales. La capture et le contrôle de cette électricité peut être un défi, mais nous pourrions puiser directement dans ce champ électrique, en arrachant littérallement l’électricité de l’air. Le potentiel de cette technologie est immense.

Une entreprise travaille déjà sur le développement de l’énergie atmosphérique : SEFE, Inc. Ils ont déjà quatre brevets approuvés, trois en attente, et dix neuf en cours de recherche et développement. Voir la vidéo sur la mission de la SEFE :

– Les nanotechnologies

Crédit photo : ©Paul Fleet/Shutterstock

Ce sont parfois les petites choses qui font les plus forts impacts. C’est certainement le cas avec ces nanotechnologies qui sont essentiellement des manipulations de matériaux à l’échelle atomique et moléculaire.

Les nombreuses applications de nanotechnologies sont trop nombreuses pour les citer ici. La nanoélectronique a le potentiel de révolutionner l’informatique, non seulement en faisant des vitesses de calcul ultra rapides, mais en réalisant des appareils électroniques plus petits. Des machines de la taille de cellules pourront un jour naviguer à travers notre corps comme un système immunitaire artificiel. Les nanodispositifs pourront un jour être capables de manipuler notre code génétique, ou peut-être même fusionner avec lui. La nanotechnologie nous permettra d’inventer de nouveaux matériaux avec une vaste gamme d’applications : en 2008, plus de 800 produits nanotechnologiques ont déjà été rendus publiques, et de nouveaux produits arrivent sur le marché au rythme de trois à quatre par semaine.

Des scientifiques viennent de mettre au point un système de mesure de la glycémie en utilisant les avancées nanotechnologiques : comment pourraient-elles aider à détecter la glycémie dans les larmes en les intégrant dans des lentilles de contact. Une équipe américaine de l’Université de Purdue vient de mettre au point, toujours grâce aux avancées des nanotechnologies, un système de mesure du glucose qui serait aussi efficace dans le sang que dans la salive, l’urine et les larmes, donc par une mesure non invasive.

Autre exemple, Nanobiotix, société de nanomédecine spécialisée en radiothérapie : les nanotechnologies permettraient de traiter de façon plus sûre et plus efficace toute une variété de cancers via une radiothérapie classique. Pratiquée depuis des décennies, la radiothérapie reste un élément clé de l’arsenal anti-cancer: 60% des patients atteints en bénéficient à un stade ou un autre de leur traitement. Le principe est simple: les rayons X peuvent détruire toute cellule cancéreuse de quelque type qu’elle soit. La seule limite réside dans la dose que peuvent tolérer les tissus sains situés alentour. La technologie «NanoXRay» s’appuie sur des nanoparticules brevetées. Seuls ces éléments de «l’infiniment» petit (50 nanomètres, soit 5 centièmes de micron) sont capables de pénétrer dans les cellules (de taille très variable, les plus petites atteignant tout de même quelques microns). Les nanoparticules cristallines mises au point par Nanobiotix, non toxiques pour l’organisme, ont la propriété de multiplier jusqu’à neuf fois la dose de radiothérapie reçue spécifiquement dans les cellules visées. La promesse du groupe est donc de permettre une bien meilleure efficacité à dose équivalente ou bien de pouvoir traiter par des doses moindres des patients qui ne supporteraient pas une radiothérapie conventionnelle (Source : Le Figaro.fr / 11 oct 2012).

– La réalité Augmentée

– La réalité Augmentée

Credit photo : ©Max Braun/Flickr

Beaucoup de bruit a été fait récemment autour des lunettes de Google ; mais même si l’invention peut paraître « accessoire », la technologie de réalité augmentée a le potentiel de changer radicalement notre monde et notre façon d’interagir avec elle.

Vous avez entendu parler de la réalité virtuelle, qui est un environnement simulé par ordinateur. La réalité augmentée, elle, est une fusion par ordinateur de données sensorielles avec le monde réel. Plutôt que de créer un monde simulé, la réalité augmentée a le pouvoir de réellement améliorer notre perception du realworld.

La technologie a tout le potentiel pour permettre de contrôler l’information dans le monde en temps réel, un peu comme vous pouvez contrôler l’information à l’aide d’un appareil à écran tactile. Fondamentalement, la réalité augmentée nous rapproche un peu plus près de notre technologie de fusion avec la réalité.

Une des innovations les plus spectaculaires du dernier Mondial de l’automobile de Paris a été certainement la présentation du pare-brise de réalité augmentée. Cette technologie permet l’affichage couleur d’informations liées à la conduite (vitesse, conditions de circulation, GPS, distance avec le véhicule précédent…) sur le pare-brise via un système de projection/surimpression. Une technologie nommée Head-up display (affichage tête haute) déjà commercialisée au Japon (3 000 euros environ) depuis le mois d’août dernier. Le fabricant japonais Pioneer a en effet présenté son pare-brise équipé du système Cyber Navi qui affiche en temps réel un écran interactif de 90 x 30 grâce à un projecteur laser fixé sur le pare-soleil. En cours d’homologation en Europe, ce dispositif devrait être commercialisé en France courant 2013.

Motorola Mobility, filiale de Google, a acquis récemment l’entreprise américaine Viewdle, spécialisée dans les applications de reconnaissance faciale, de reconnaissance d’objets et de gestes. Ses produits permettent par exemple le taggage automatique de photographies sur Internet.

Autre exemple, la société Smartsy : cette start-up française, implantée aux USA, ne se situe pas seulement dans le domaine de la réalité augmentée mais aussi dans celui de la reconnaissance visuelle universelle. Smartsy permet de lier tout objet, document, image, produit de consommation courante, bâtiment ou monument, …à des informations enrichies et partageables. Une plateforme mobile d’informations et de diffusion qui fait donc le lien entre le monde physique et le monde digital.

– Le carburant solaire

– Le carburant solaire

Credit photo : ©Chris Harvey/Shutterstock

Nous le savons tous, le développement des énergies renouvelables est primordial pour entrer dans l’avenir. Les technologies existantes comme l’énergie éolienne, solaire et hydraulique sont d’excellents moyens de production d’électricité renouvelable, mais qu’en est-il de la production réelle de combustible? Les biocarburants sont utiles, mais ils ont aussi beaucoup d’impacts négatifs pour l’espace agricole et notre approvisionnement alimentaire.

Et si nous pouvions convertir directement l’énergie solaire en un carburant liquide ? D’où l’ idée d’un combustible solaire qui pourrait être produit avec une technologie imitant la façon dont les plantes produisent de l’énergie grâce à la photosynthèse. Un combustible solaire qui pourrait également révolutionner la façon dont l’énergie renouvelable est stockée. Cela nous permettrait de garder l’énergie du soleil sous forme liquide.

Une société travaille à rendre cette vision possible au Massachusetts / USA : Joule Unlimited. Leur technologie est capable de créer un carburant en utilisant la lumière du soleil avec du dioxyde de carbone et de l’eau non potable. Ils pensent pouvoir être bientôt en mesure de produire ce carburant à un prix compétitif avec l’essence.

– Les Cellules souches modifiées

– Les Cellules souches modifiées

Credit photo : ©Andrea Danti/Shutterstock

Peu de technologies ont le pouvoir de transformer la médecine plus que l’ingénierie des cellules souches. Non seulement les cellules souches sont génétiquement programmées pour attaquer les maladies comme le VIH ou le cancer, mais elles sont maintenant utilisées pour générer des tissus vivants.

Le but ultime d’une telle technologie sera de stimuler la repousse des organes. Une fois mis au point, il peut être possible de prolonger indéfiniment la vie humaine. Imaginez si chacun de vos organes pouvait simplement être remplacé, comme une simple pièce de voiture…

La société française de biotechnologie Cellectis vient de décrocher un contrat de 9,5 millions de dollars sur cinq ans auprès du National Institutes of Health (NIH) et de plusieurs organismes gouvernementaux américains pour la fourniture de cellules iPS. Cellectis s’appuie sur la technologie qui a valu le prix Nobel de médecine 2012 à son inventeur, Shinya Yamanaka.

A l‘Université libre de Bruxelles (ULB), des cellules souches embryonnaires (ES) ont été utilisées pour la première fois pour recréer la thyroïde d’une souris qui n’en avait pas, ce qui ouvre de nouvelles perspectives pour l’utilisation thérapeutique de ces puissantes cellules « pluripotentes ».

– Le transfert d’énergie sans fil

– Le transfert d’énergie sans fil

Credit photo : ©Fotovika/Shutterstock

Les appareils sans fil sont omniprésents aujourd’hui, relié par un seul fil, rien de plus. Alors que nous pouvons transmettre des informations sans fil autour de nous, nos appareils électriques doivent toujours, dans l’ensemble, recevoir leurs pouvoirs de connexions câblées. Mais imaginez pouvoir utiliser l’énergie du faisceau d’une source d’alimentation directement dans un appareil, sans la nécessité d’un fil.

La technologie de transfert d’énergie sans fil existe déjà, mais doit encore être perfectionnée. Il s’agit en général d’ un problème d’efficacité : trop d’énergie est perdue quand elle est téléportée.

Comme la technologie évolue, on peut désormais imaginer un monde où rien ne sera plus branché. Plus incroyable, la technologie pourrait révolutionner l’exploration spatiale. Non seulement le pouvoir pourrait être dirigée vers les satellites, les stations spatiales, et des navettes spatiales de la Terre, mais la puissance collectée dans l’espace pourrait être aussi renvoyée à la Terre.

En 2006, Marin Soljačić ainsi que d’autres chercheurs du Massachusetts Institute of Technology (MIT) proposent une nouvelle application de transfert d’énergie sans fil, en se basant sur la théorie de l’électromagnétisme à champ proche, et l’utilisation de « résonateurs couplés »7,8. Le 7 juin 2007 un prototype est réalisé par le MIT : WiTricité permet d’alimenter une ampoule de 60 watts à une distance de 2 mètres, avec un rendement de 40 %. Le principe est basé sur le phénomène d’induction. Une bobine dans laquelle circule un courant électrique génère un champ magnétique qui lui-même génère du courant dans une bobine équivalente placée à proximité.

– Les bases spatiales d’énergie solaire « Space Based Solar »

– Les bases spatiales d’énergie solaire « Space Based Solar »

Credit photo : © NASA

La grande majorité de l’énergie contenue sur la Terre provient du Soleil. Notre capacité à exploiter cette puissance dépend de l’efficacité que nous pouvons récolter. La technologie solaire demande de capter l’énergie du soleil, mais tous les collecteurs solaires basés sur la Terre sont limités parce que l’atmosphère dévie beaucoup l’énergie du Soleil. Et si nous pouvions rassembler de vastes ensembles de panneaux solaires dans l’espace ?

Astrium étudie actuellement de nouvelles technologies de transfert d’énergie solaire orbitale vers la Terre. Une telle technologie fournirait ainsi une énergie propre, à partir d’une source inépuisable, et ferait partie d’un ensemble de solutions neutres à long terme et instamment nécessaires pour répondre durablement aux besoins énergétiques effrénés de notre planète.

Baptisé « Space Based Solar Power » (SBSP) – ou énergie solaire spatiale -, ce projet de recherche étudie la possibilité d’utiliser des plates-formes spatiales – essentiellement de grands satellites – pour capter les rayons du Soleil et les rediriger par faisceaux laser, à des longueurs d’onde inoffensives pour l’œil, vers des récepteurs terrestres spécialement équipés. Les lasers de bord transmettraient l’énergie à des puissances comparables au rayonnement solaire normal, et donc totalement sécurisé pour les humains et animaux qui le franchiraient.

Placée de préférence en orbite géostationnaire (GTO), la plate-forme SBSP serait ainsi visible en permanence par les récepteurs terrestres. De là, l’énergie pourrait être dirigée vers des sites implantés sur la partie visible de la surface du globe. Avec les technologies potentiellement disponibles à relatif court terme, un seul satellite permettrait de fournir environ 10 kW à l’utilisateur final, au sol, avec un système de transmission laser. Cette composante de base et les améliorations qui lui seraient apportées pourraient alors servir à fabriquer des systèmes multi-satellites, fournissant de l’énergie aux utilisateurs privés d’accès aux réseaux électriques existants.

Astrium maîtrise déjà et a fourni, pour un certain nombre de programmes, les briques technologiques essentielles pour faire de ces programmes une réalité – satellites de télécommunications haute-puissance, miroirs spatiaux (comme celui développé pour l’observatoire Herschel) et technologie laser.

– La Téléportation quantique

– La Téléportation quantique

Credit photo : ©lightpoet/Shutterstock

La téléportation n’est pas seulement de la science-fiction : la téléportation quantique est le transfert instantané d’un état quantique d’un endroit à un autre.

Albert Einstein appelait cela l’intrication quantique, une sorte « d’action fantôme » à distance. Et ce phénomène physique est au cœur de la nouvelle génération à venir d’ordinateurs quantiques ultra-puissants « bits quantiques » de l’information, ainsi que des systèmes de communication immunitaire à interception.

Une équipe internationale de chercheurs, utilisant la station optique au sol de l’ESA dans les îles Canaries, a établi un nouveau record mondial de distance de «téléportation quantique» en séparant sur 143 kms de distance un photon. Financés par l’ESA, des chercheurs autrichiens, canadiens, allemands et norvégiens ont transféré les propriétés physiques d’une particule de lumière – un photon – vers son « double » via la téléportation quantique, sur une distance de 143 km entre le télescope Jacobus Kapteyn de La Palma et la station au sol de l’ESA à Tenerife.

Au-delà de surprendre ou fasciner, la téléportation quantique est amenée à jouer un rôle central dans les communication cryptées du futur. Le problème du cryptage concerne la sécurité de la transmission entre l’émetteur et le récepteur, la clef de décryptage pouvant être interceptée. La téléportation quantique, par ses propriétés intrinsèques basées sur les lois de la mécanique quantique, rend cette interception impossible et la transmission sûre à 100%. Par la méthode qu’ils ont utilisé et les résultats qu’ils ont obtenus, les chercheurs de l’ESA ont démontré la possibilité de réaliser dans la pratique ces communications quantiques. La prochaine étape pour eux : établir une téléportation quantique entre la Terre et un satellite en orbite.

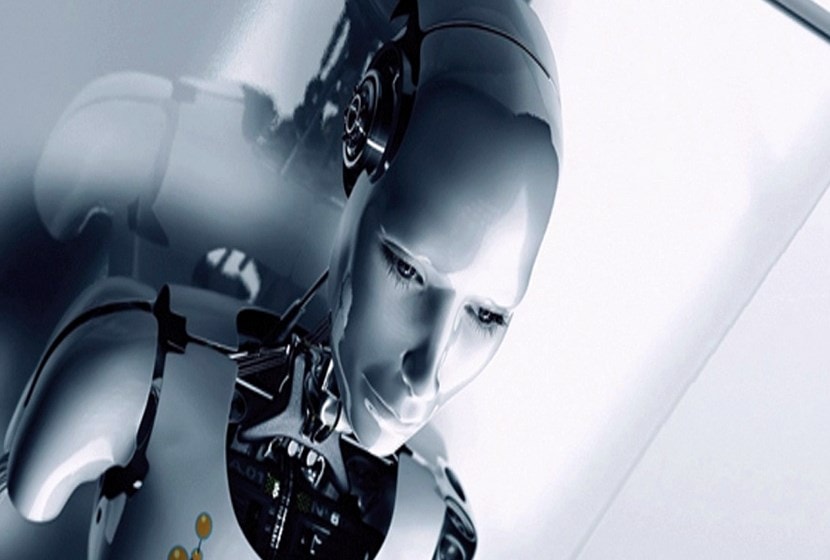

– L’Intelligence artificielle

– L’Intelligence artificielle

Credit photo : © Ociacia/Shutterstock

La première image que l’on a quand on pense « intelligence artificielle » est celle de Terminator, ou peut-être HAL de 2001: A Space Odyssey. Il est vrai que le développement de l’intelligence artificielle pose quelques grandes questions philosophiques et éthiques, mais il y a peu de doute pour que la technologie aboutisse.

La puissance de traitement des ordinateurs continue de croître à un rythme effarant. En conséquence, nous sommes en mesure d’analyser les données à l’aide de modèles informatiques de plus en plus complexes, et à résoudre les problèmes de façons encore plus ingénieuses.

Jusqu’à présent, nous devons encore créer une machine avec une conscience artificielle, ou la conscience de soi. Mais cela, aussi, est probablement inévitable.. Des ingénieurs estiment que la conscience artificielle sortira en 2045.

En attendant, Google a dévoilé un logiciel qui reproduit la manière dont les neurones du cerveau humain communiquent et interagissent entre elles. La firme avait pour cela mis au point une machine, en connectant 16’000 processeurs informatiques, capable de reconnaître des choses dans des vidéos YouTube, tels que des chats, des visages humains ou d’autres objets. Cette technologie d’intelligence artificielle va à présent sortir des murs des laboratoires pour être mise à contribution dans des produits du géant du web, à commencer par le système de reconnaissance vocale de la firme. (Source : 20 minutesonline / 8 oct 2012).

Le test de Turing est une proposition de test d’intelligence artificielle fondée sur la faculté d’imiter la conversation humaine. Décrit par Alan Turing en 1950 dans sa publication Computing machinery and intelligence,ce test consiste à mettre en confrontation verbale un humain avec un ordinateur et un autre humain à l’aveugle. Si l’homme qui engage les conversations n’est pas capable de dire lequel de ses interlocuteurs est un ordinateur, on peut considérer que le logiciel de l’ordinateur a passé avec succès le test. Cela sous-entend que l’ordinateur et l’homme essaieront d’avoir une apparence sémantique humaine (Source Wikipedia).

Or, le mythe de l’Homme se faisant dépasser par la machine qu’il aurait lui-même créé est en passe de devenir une réalité, ou presque. En effet, lors d’une compétition sponsorisée par 2K Games, le BotPrize, deux équipes de scientifiques, l’une de l’université d’Austin (Texas), et l’autre roumaine, ont réussi à démontrer qu’ils avaient créé un modèle d’intelligence artificielle pour Unreal Tournament 2004 dont le comportement et les réactions en jeu étaient plus « humaines » que celles d’un véritable humain ! Plus concrètement, il s’agissait d’opposer dans un mode compétitif un panel de joueurs composé pour moitié d’humains (des juges) et pour moitié de bots, chaque humain disposant d’une sorte de tagger en plus de ses armes classiques. Ce tagger sert notamment à marquer une cible, pour indiquer si la personne estime qu’il a affaire à un bot ou à un humain. Au bout du compte, le bot le plus taggé remporte la victoire. Dans le cas présent, les modèles vainqueurs, UT^2 et MirrorBot, ont obtenu chacun un indice d’humanité de 52 %, alors que le premier humain arrive loin derrière, avec un indice de seulement 42%.

Le principe de Singularité défend l’émergence d’une société dont les progrès ne seraient plus l’apanage de l’Homme, mais celui d’une intelligence artificielle supérieure. On voit là, qu’au sein de l’université d’Austin, ces scientifiques travaillent à ce que cette théorie devienne plus qu’un mythe…

{jacomment on}