Le pôle de recherche Département sociétés humaines et responsabilités éducatives du Collège des Bernardins a organisé en avril dernier une conférence sur le thème « Journalisme et bien commun, l’heure des algorithmes », avec comme intervenants Thomas Kent de l’agence de presse Associated Press et Martin Chodron de Courcel, Professeur de philosophie en khâgne Ulm Lycée Henri IV Paris.

Résumé de la séance.

La multiplication des robots journalistes débarrasse les professionnels des tâches ingrates et permet de produire un volume d’articles plus important. Si pour l’instant les algorithmes ne sont pas capables d’établir des conclusions, ils font tout de même éclore des questionnements sur le statut à accorder à ces productions.

Thomas Kent, directeur adjoint de la rédaction de l’agence de presse américaine Associated Press, a évoqué l’utilisation du robot journalisme (transformation des données brutes en un papier qui semble être écrit par un humain) et les réflexions générales qui en découlent.

Pour l’instant, les données qui parviennent à ces robots doivent être structurées. Un algorithme va ensuite reformater ces informations selon un papier modèle. De plus en plus, les ordinateurs parviennent à réaliser une véritable évaluation des données, qu’ils classent selon des priorités établies par les journalistes, et utilisent un vocabulaire contrôlé pour écrire les dépêches. Par exemple, en ce qui concerne la rédaction d’un compte-rendu sportif, le logiciel est capable de remarquer des événements inhabituels parmi les données transmises (nombre de buts inhabituel…), en s’appuyant sur une liste de priorités établie par les journalistes.

Le robot est limité par le format des données, qui n’intègre pas pour l’instant les citations de joueurs et les événements annexes comme des bagarres dans les tribunes.

Plusieurs enjeux émergent :

– Dans la mesure où les données n’émanent pas nécessairement de sources fiables, comment assurer leur probité ?

– Peut-on utiliser librement les données transmises ?

– Comment communiquer sur l’origine des articles ?

L’agence Associated Press mentionne l’origine robotique des articles en présentant le nom de la société qui a crée l’algorithme. On peut imaginer qu’à l’avenir des comptes soient demandés aux journaux sur le processus de traitement des données. Les journalistes ont la responsabilité de tous les contenus produits, qu’ils émanent d’humains ou de robots. Ces derniers sont paramétrés selon des choix éditoriaux, un vocabulaire spécifique…

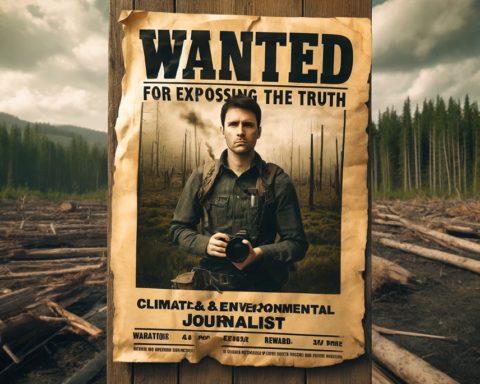

– Quel avenir pour les journalistes ? Le développement du robot journalisme menace uniquement les journalistes qui sont cantonnés à des tâches répétitives, comme la présentation de résultats financiers. Les algorithmes peuvent les libérer de ce travail pénible et laisser plus de temps pour la rédaction d’articles de fond.

Martin Chodron De Courcel estime que, dans la mesure où les robots peuvent remplacer les journalistes dans la rédaction d’articles, qui remplit la fonction d’ingénieur, d’exécutant ?

Il est nécessaire de s’attarder sur l’expression «big data». C’est la dimension quantitative qui est la plus importante, celle qui rend nécessaire les robots, esclaves du traitement de l’information. Ces big data sont intrinsèquement inutilisables et les robots les sauvent d’un naufrage annoncé. La réflexion peut être prolongée en posant la question suivante : qu’est-ce qu’un article ?

S’il est facile de transformer des données brutes en article, cela indique que l’article existe en puissance dans ces données. Alors, les robots seraient les sculpteurs de cette matière informe. Ont-ils cette capacité ? Les robots peuvent-ils œuvrer dans un monde qui n’est pas celui de la série ?

Une autre question suit : qu’est-ce qu’un article de fond ? N’est-ce pas un papier singulier, qui ne ressemble à aucun autre ?

Selon le public présent, la production des robots reste pour l’instant prévisible ; ils ne sont pas encore capables d’établir des conclusions à partir de données : les journalistes restent indispensables pour faire surgir du sens. Les logiciels doivent être considérés comme un soutien pour la mise en lumière de tendances, corrélations.

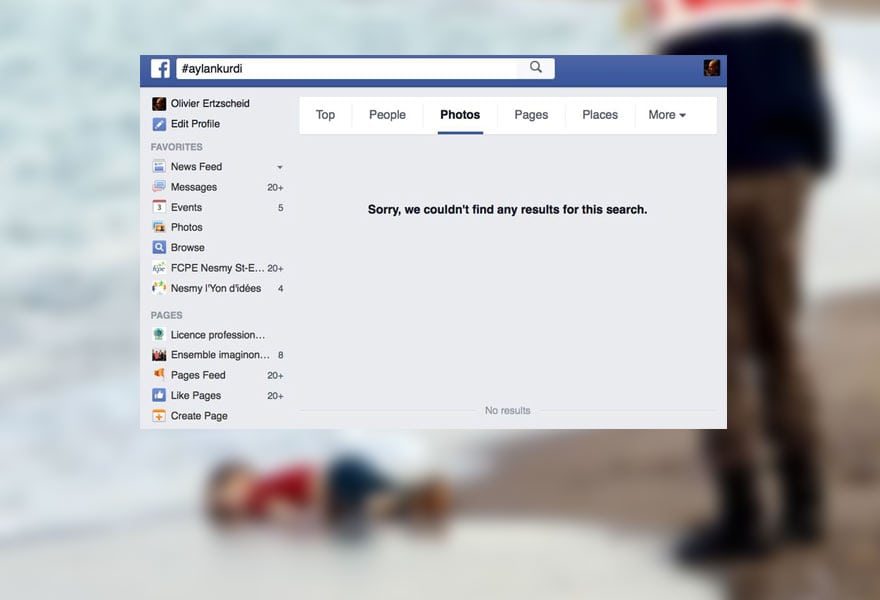

Dans un contexte d’infobésité, n’est-il pas plus pertinent de mobiliser les algorithmes afin de renforcer la filtration des contenus ?

La personnalisation de l’accès aux informations par l’intermédiaire des algorithmes remet en cause le rôle de ferment de l’espace public que sont supposés tenir les médias. Pire, la discrétion des algorithmes laisse croire que l’on est dans un espace public partagé, alors que la personnalisation croissante suscite de l’incompréhension entre les individus.

Finalement, est-ce que le caractère novateur du robot journalisme n’est pas exagéré ? La data est une source qui n’est pas nouvelle dans son principe. Par contre, le défi inédit se trouve dans la quantité.

Ne cherche-t-on pas un alibi dans la machine pour reporter notre responsabilité ?

Les salles de rédactions seront composées de codeurs, de techniciens, et de journalistes. Pour que ces professionnels se comprennent, il est essentiel qu’ils partagent une langue commune, une manière de raisonner. Il s’agit de favoriser l’intercompréhension et non d’intervertir les savoir-faire.

Si les robots ne sont pas capables d’établir des conclusions et produisent des informations prévisibles, peut-on qualifier ces résultats d’«informations » ? En quoi cela participe à la construction d’un espace public ?

Selon une étude de fin 2013 (1), reprise par le magazine Humanoïdes.fr, notre future robotique représenterait plus de 50% des métiers qui pourront être robotisés d’ici 2030…

Franck Babeau, Collège des Bernardins

(1) Etude qui a été dirigée par Carl Benedikt Frey et Michael Osborne, deux Professeurs d’Oxford étudiant les impacts de la technologie sur notre futur d’un point de vue économique et social, s’intitulant « Le futur de l’emploi : quel degré d’automatisation sont susceptibles d’atteindre les professions ?“.

![]()

– Lire l’article UP’ Magazine « Le règne d’algorithme »

– Lire l’article du Guardian « Guarbot : Le nouveau journaliste du Guardian n’est pas un être humain »