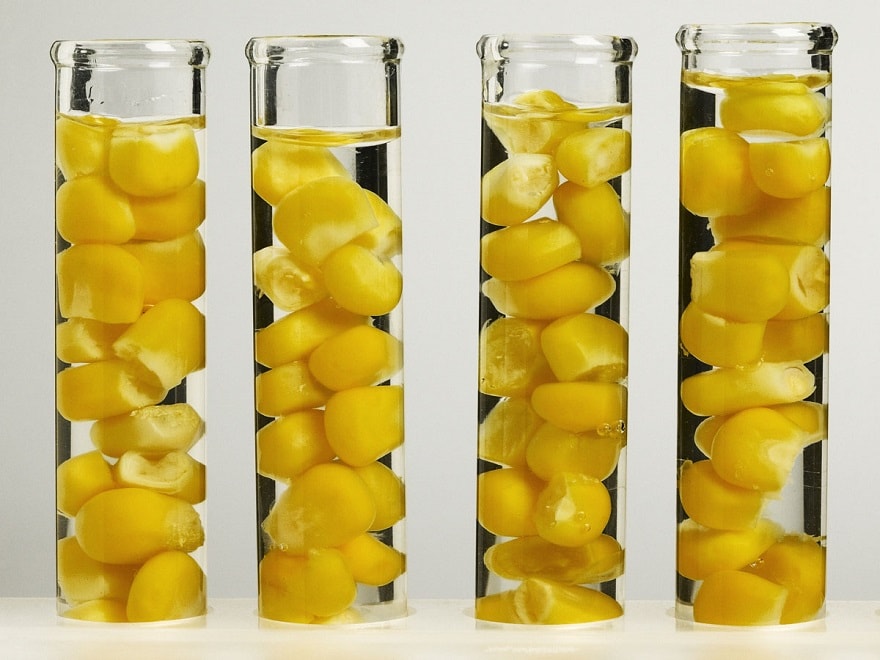

Yves Bertheau : La question de la frontière entre OGM et non-OGM nécessite en premier lieu de définir le terme d’OGM. Si, comme l’entendent généralement les biologistes, un OGM résulte d’une modification d’un génome par introduction par l’homme de réactifs spécifiques, alors ceci concerne aussi bien les OGM issus des techniques des années 70 que ceux issus de la majorité des « nouvelles » techniques de modifications des génomes comme les méthodes Crispr. Ces nouvelles techniques constituent une évolution importante dans la gamme des outils d’étude du génome par leur facilité d’usage et leur versatilité, mais n’échappent pas au côté artificiel de leur mise en œuvre par l’homme.

Yves Bertheau : La question de la frontière entre OGM et non-OGM nécessite en premier lieu de définir le terme d’OGM. Si, comme l’entendent généralement les biologistes, un OGM résulte d’une modification d’un génome par introduction par l’homme de réactifs spécifiques, alors ceci concerne aussi bien les OGM issus des techniques des années 70 que ceux issus de la majorité des « nouvelles » techniques de modifications des génomes comme les méthodes Crispr. Ces nouvelles techniques constituent une évolution importante dans la gamme des outils d’étude du génome par leur facilité d’usage et leur versatilité, mais n’échappent pas au côté artificiel de leur mise en œuvre par l’homme.LIRE AUSSI DANS UP’ : CRISPR: entre peur et euphorie, la bataille de l’éthique bat son plein